Artificial intelligence & open source

La solution logicielle Juris-Tyr dispose déjà, via Nextcloud, de fonctionnalités permettant d’accéder à des logiciels d’intelligence artificielle, grâce à l’intégration de ChatGPT ou Lllama2 …

Cependant il est intéressant de connaître d’autres logiciels d’intelligence artificielles open-source et de pouvoir, le cas échéant, les installer à coté de Nextcloud afin d’utiliser l’IA de manière plus approfondie pour votre entreprise, ou votre cabinet d’avocats, en sécurisant autant que possible vos données et celles de vos clients.

Ainsi nous proposons plusieurs tutoriels pour installer sur votre ordinateur ou sur votre serveur des logiciels d’intelligence artificielle open source qui ont retenu notre attention.

Liste des tutoriels :

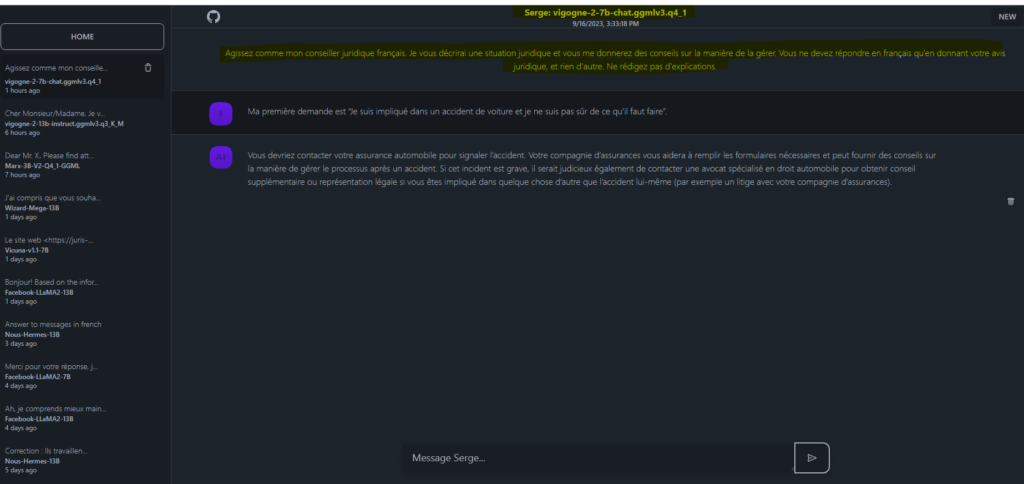

⏩ Serge : discutez avec plusieurs LLM / intelligence artificielle open source [Discussion] [LLM open source]

⏩ Ollama : accédez aux LLM open source depuis votre ordinateur personnel Mac ou PC, ou via votre serveur [Discussion]] [LLM open source]

⏩ GodMode – AI Chat Browser : comparez les LLM entre eux [Discussion] [OpenAI]

⏩ GPT4All : un logiciel à installer sur son PC sous Windows ou sur son Mac pour utiliser localement des LLM topen source [Discussion] [LLM open source]

⏩ Jan : une alternative open source à ChatGPT 100 % hors ligne sur votre ordinateur [Discussion] [LLM open source]

⏩ LMStudio : un logiciel à installer sur Windows, Linux, ou Mac pour utiliser localement des LLM open source [Discussion] [Document] [LLM open source]

⏩ LibreChat : logiciel open source pour accéder à GPT4, Claude, via leurs API [Discussion] [Document] [OpenAI]

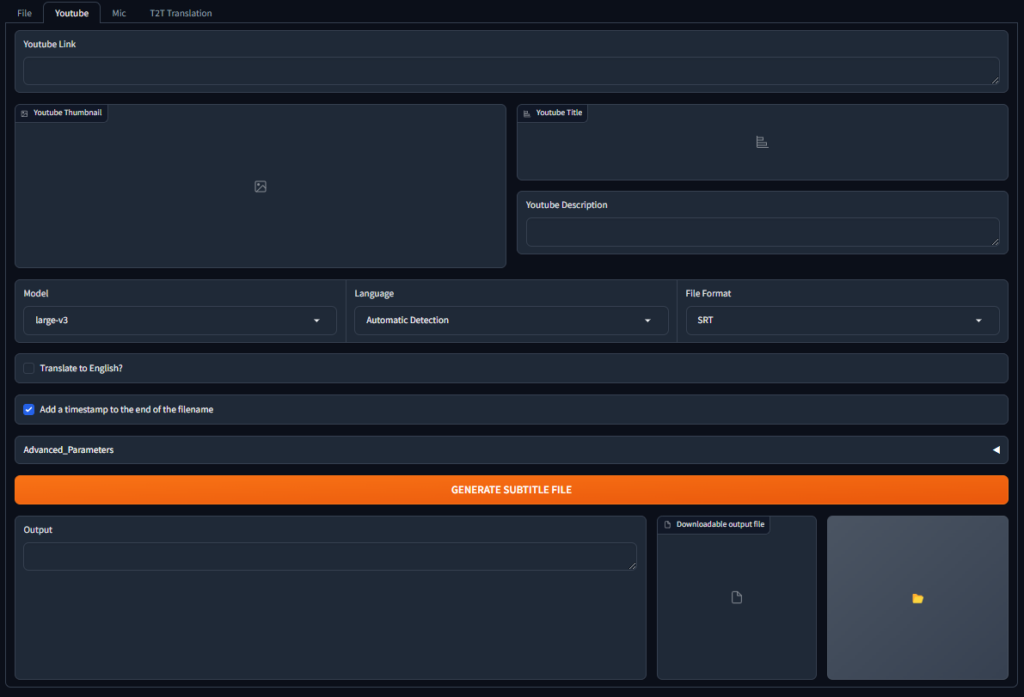

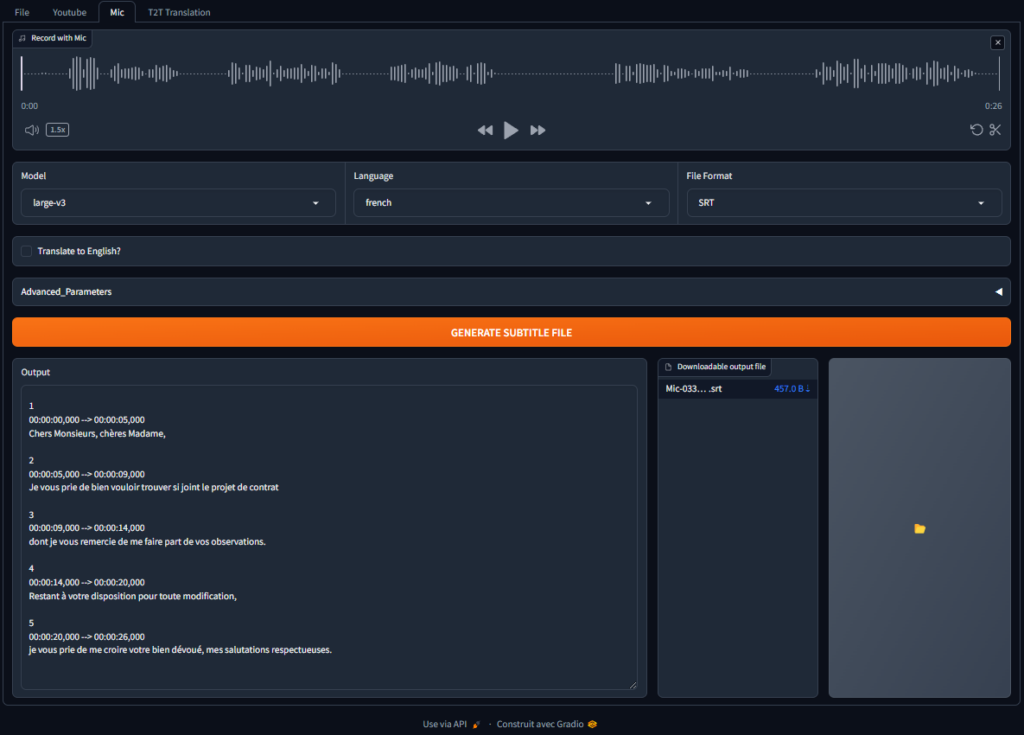

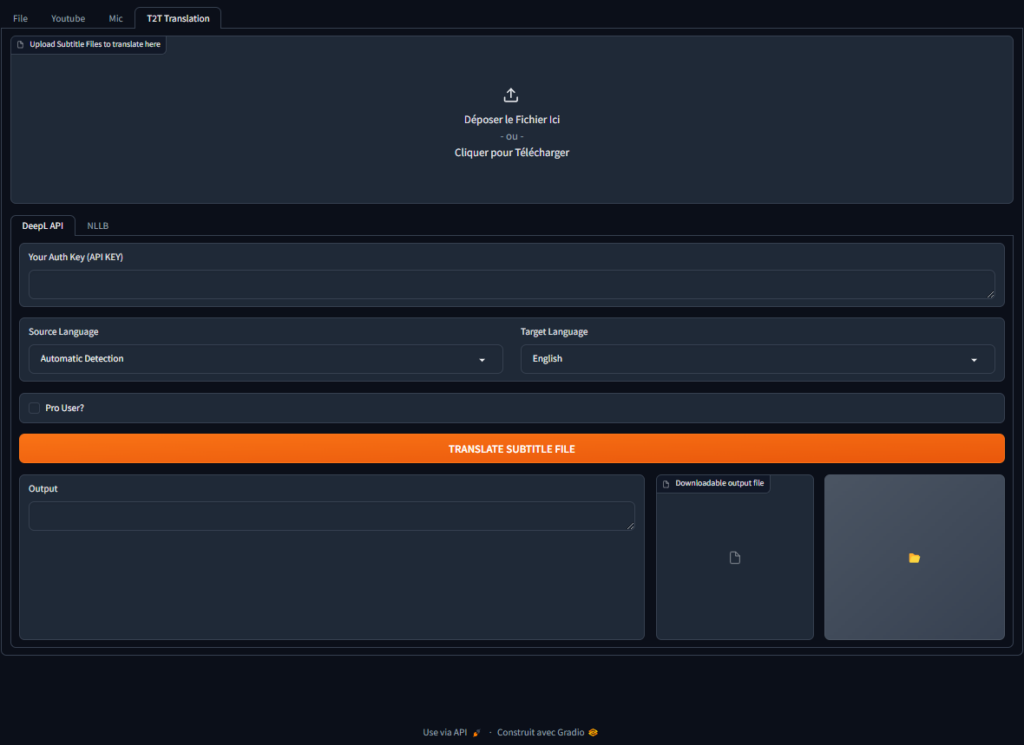

⏩ Web Whisper + : un logiciel de reconnaissance vocale en ligne [Reconnaissance vocale]

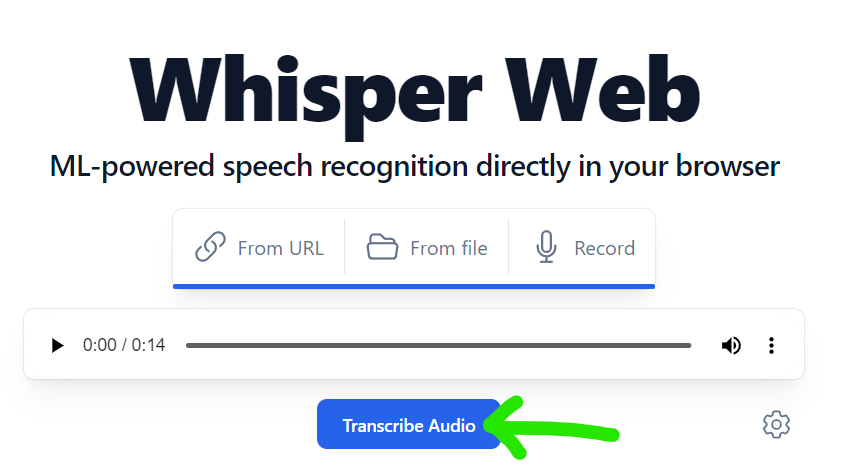

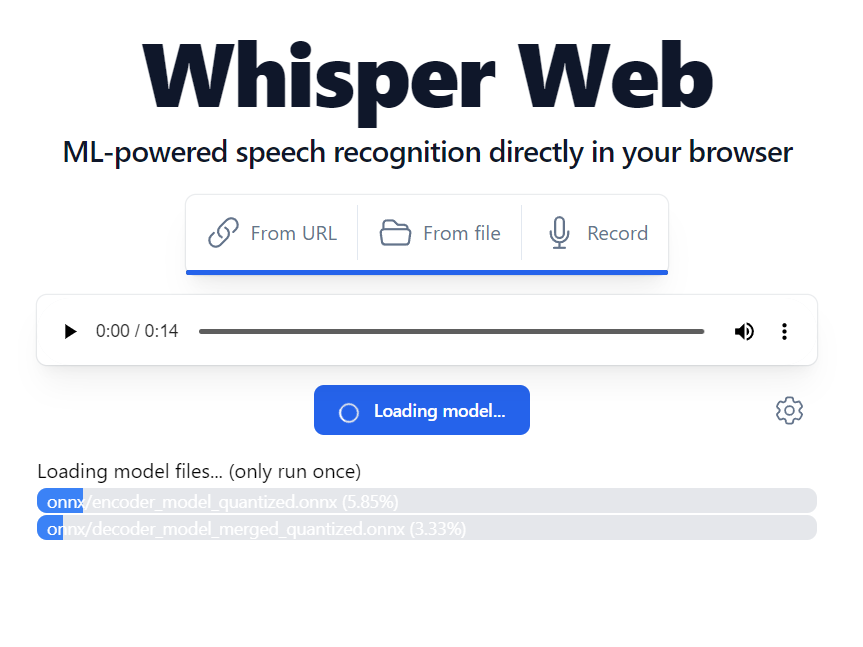

⏩ Whisper Web : un logiciel de reconnaissance vocale en ligne [Reconnaissance vocale]

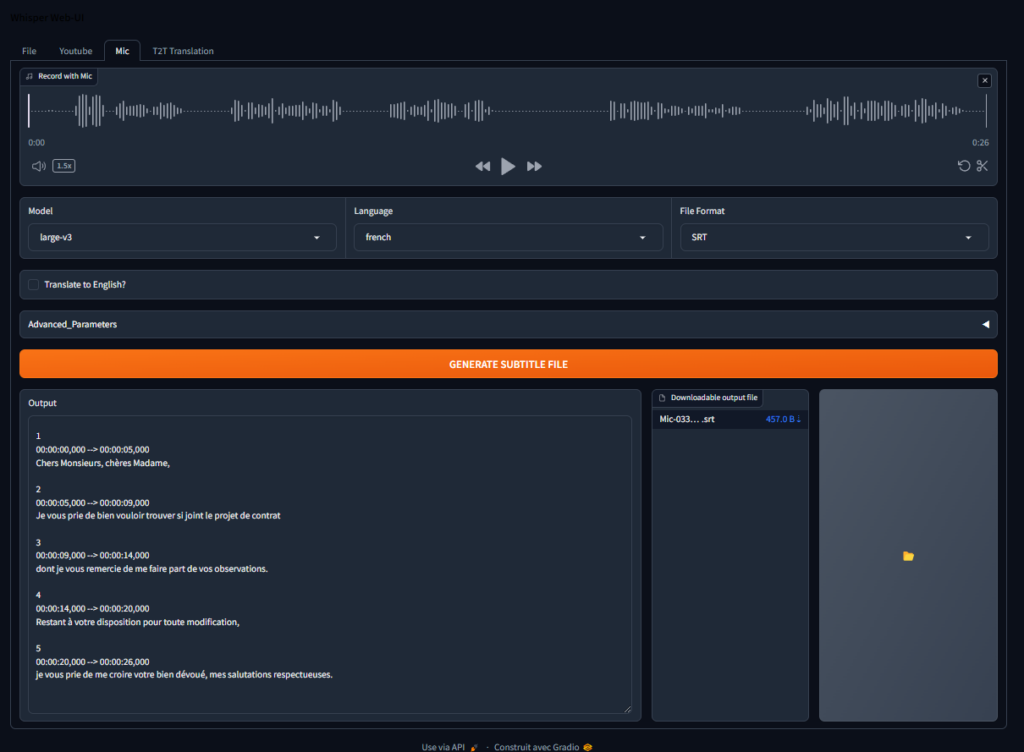

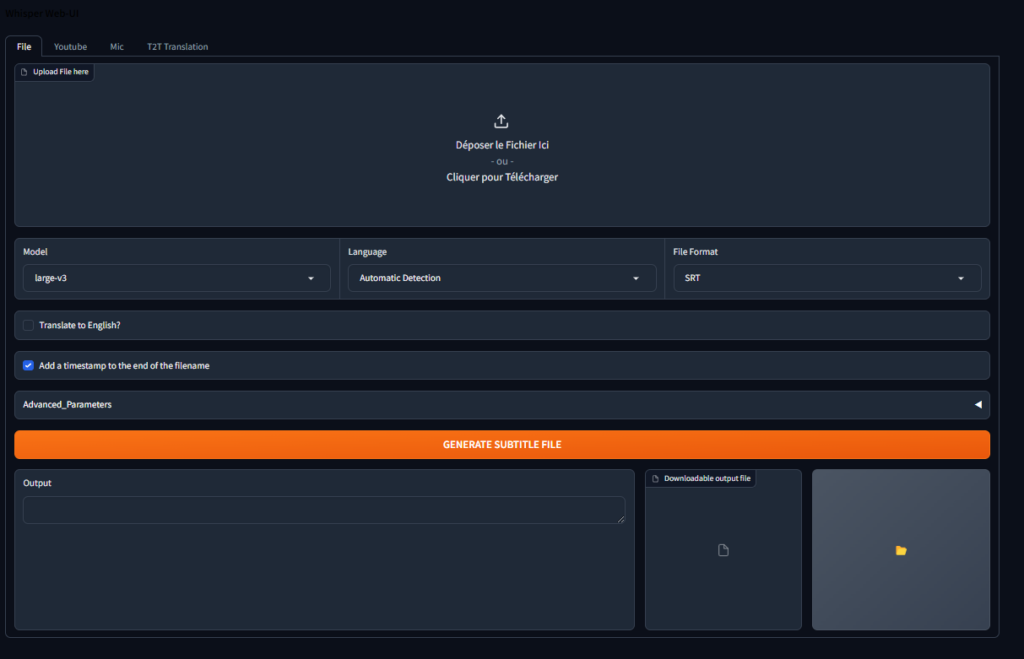

⏩ Whisper UI : un logiciel de reconnaissance vocale en ligne [Reconnaissance vocale] 🆕

⏩ Web-speech-synthesis-and-recognitiospeech : logiciel pour convertir la parole en texte et vice versa en quelques secondes [Lecture vocale]

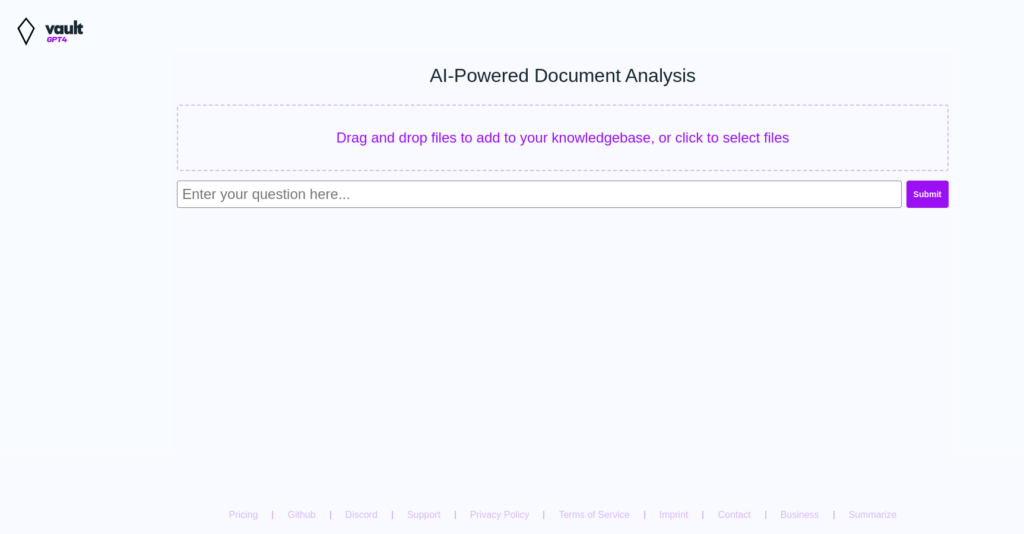

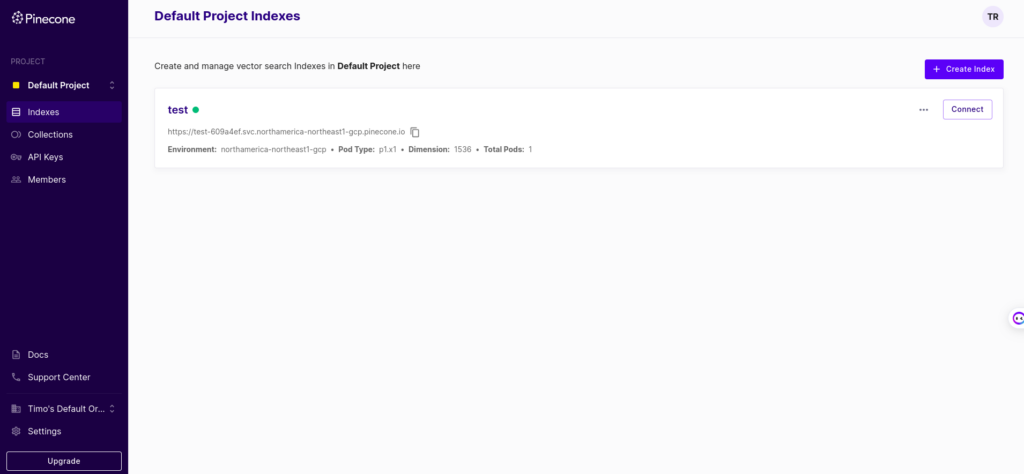

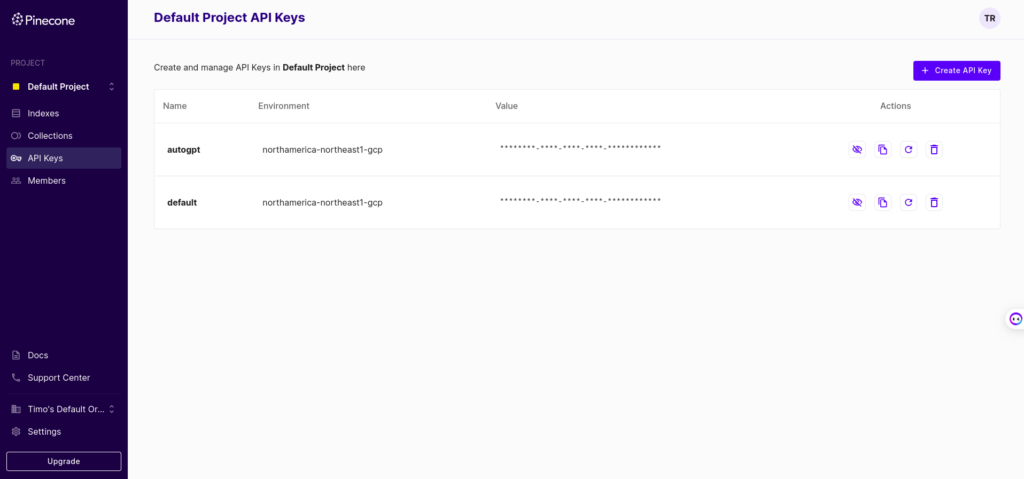

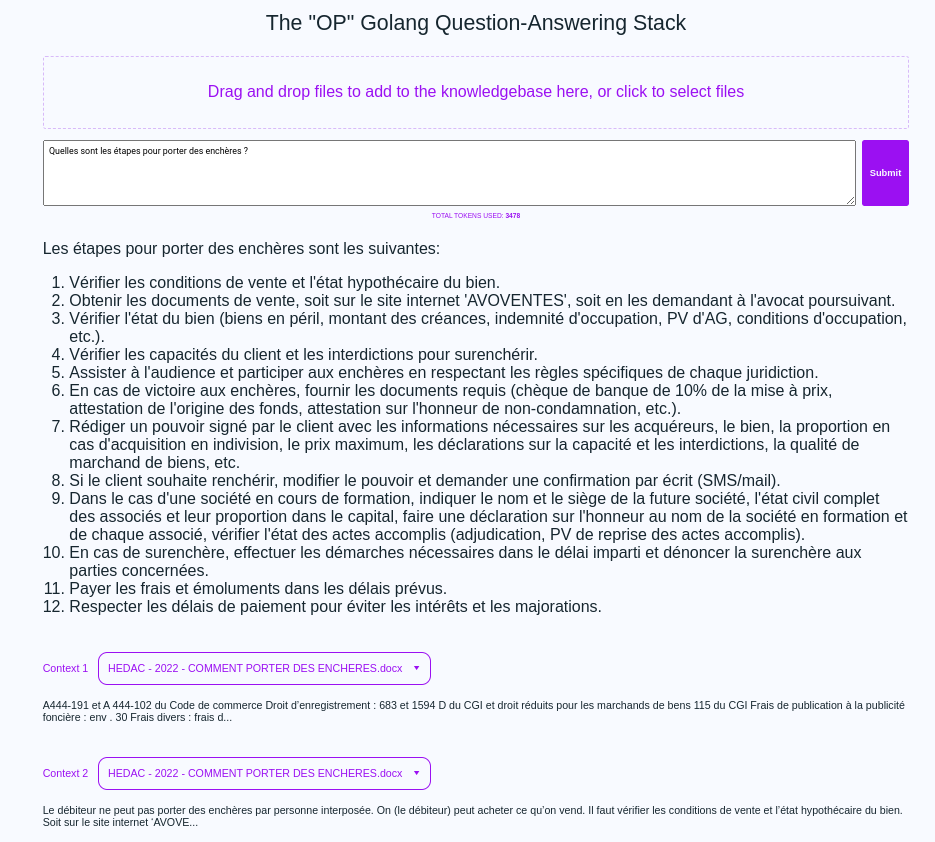

⏩ OP Vault : discutez avec des documents PDF ou DOCX via l’API de GPT4 [Discussion] [Document] [OpenAI]

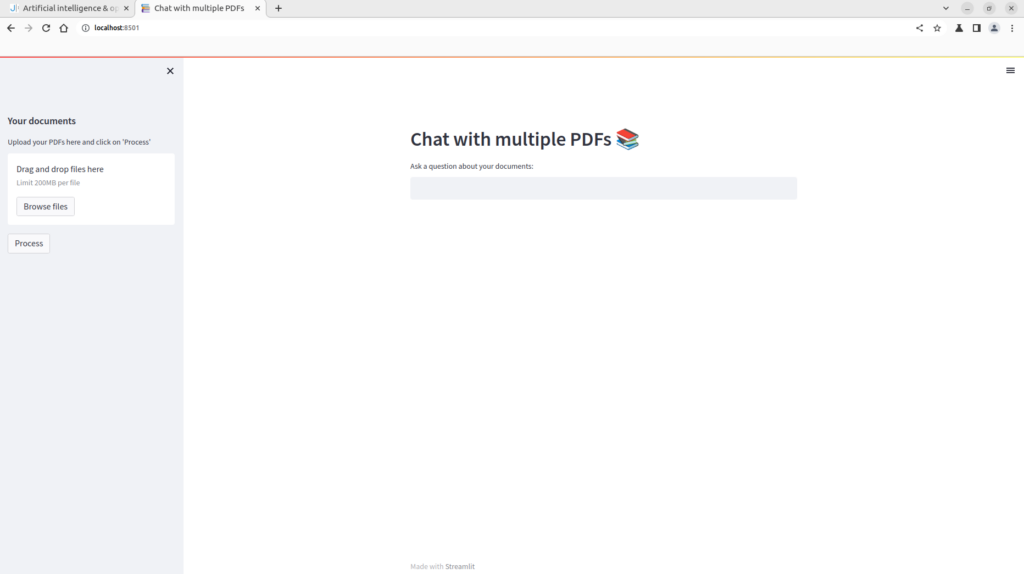

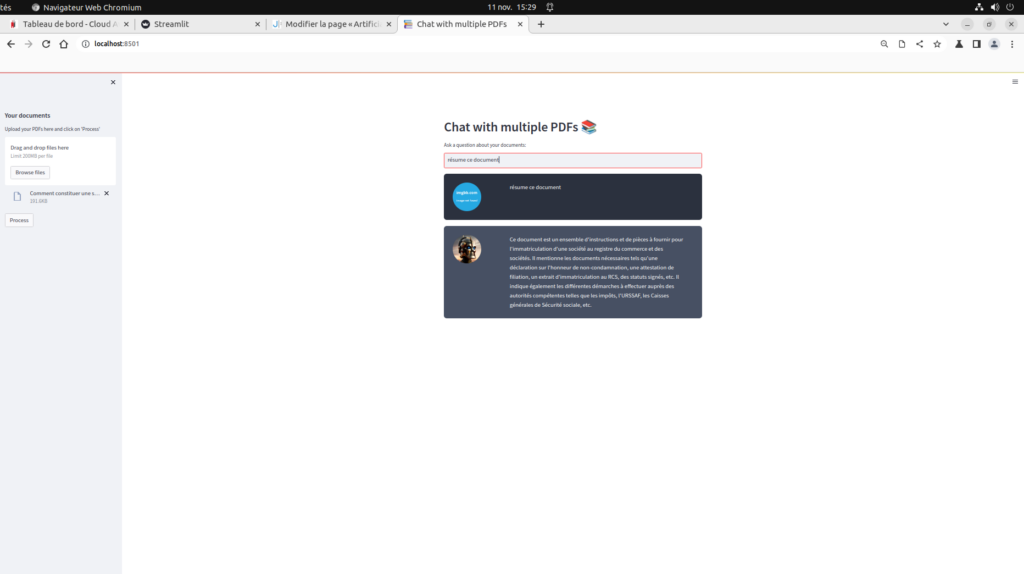

⏩ MultiPDF Chat App : Analysez plusieurs PDF en même temps via l’API de GPT4 [Document] [OpenAI]

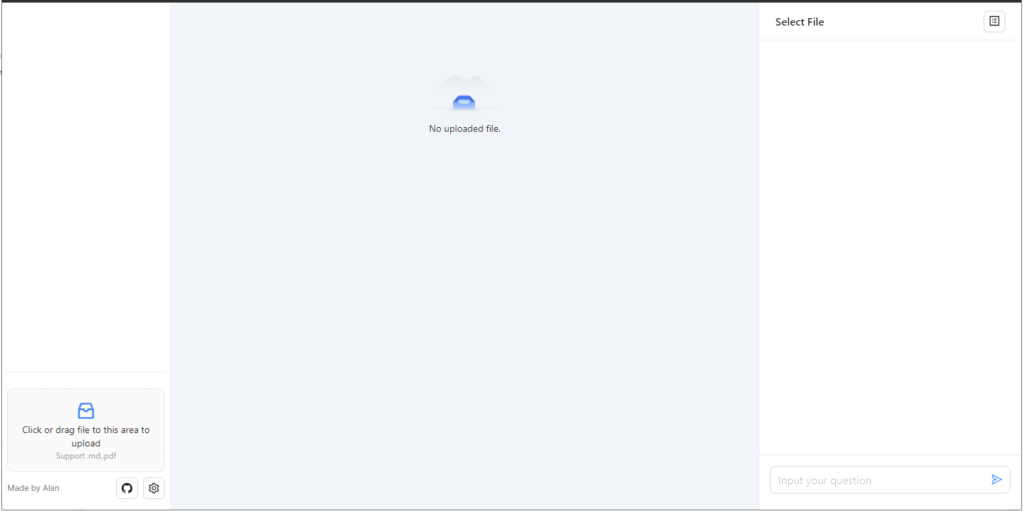

⏩ DocsMind : discutez avec un fichier PDF via l’API de GPT4 [Discussion] [Document] [OpenAI]

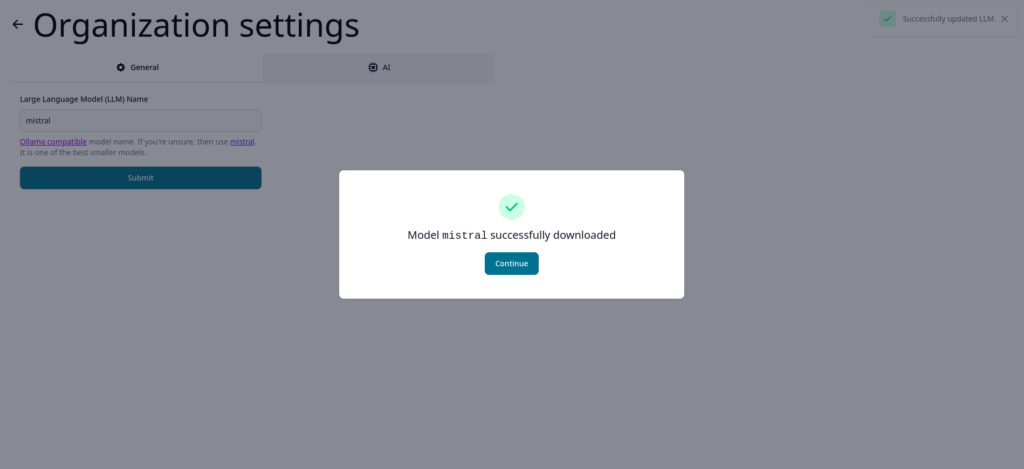

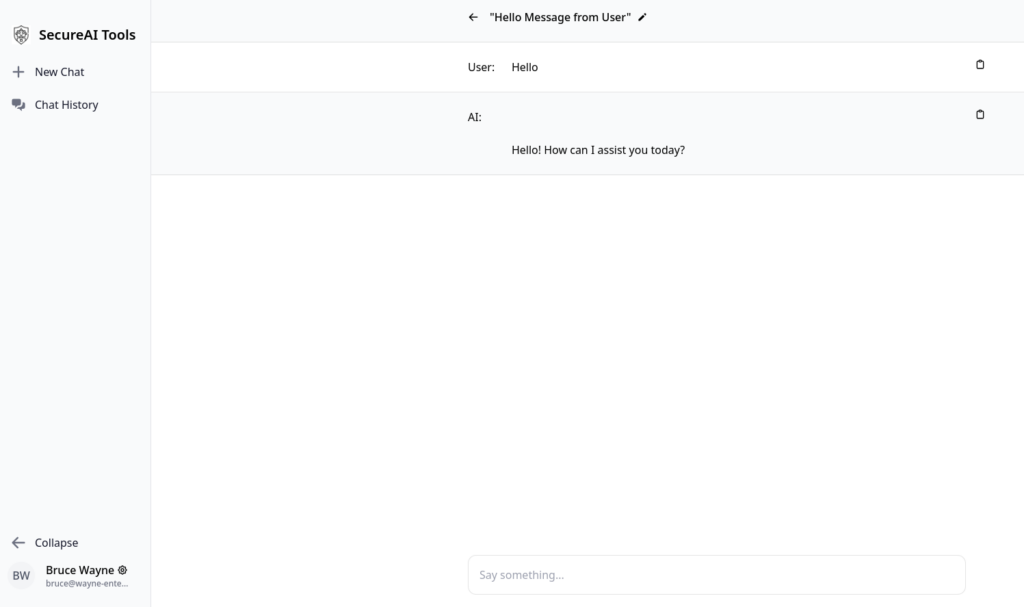

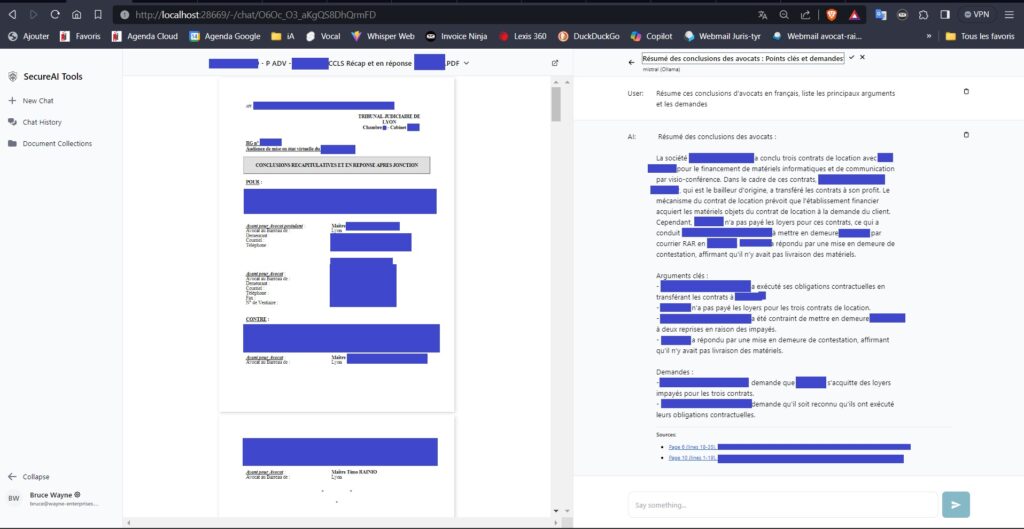

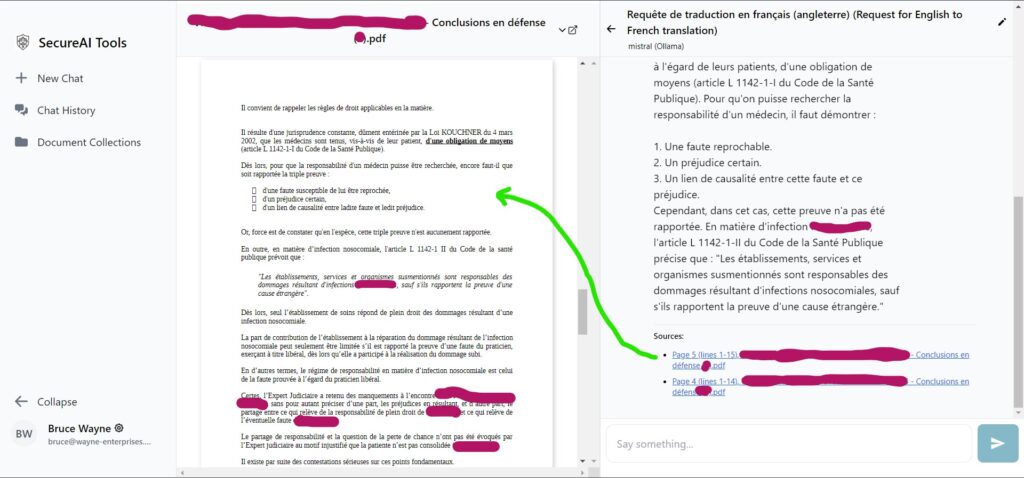

⏩ SecureAI Tools : discutez avec « MistralAI » et analysez vos fichiers PDF, de manière sécurisée [Discussion] [Document] [LLM open source]

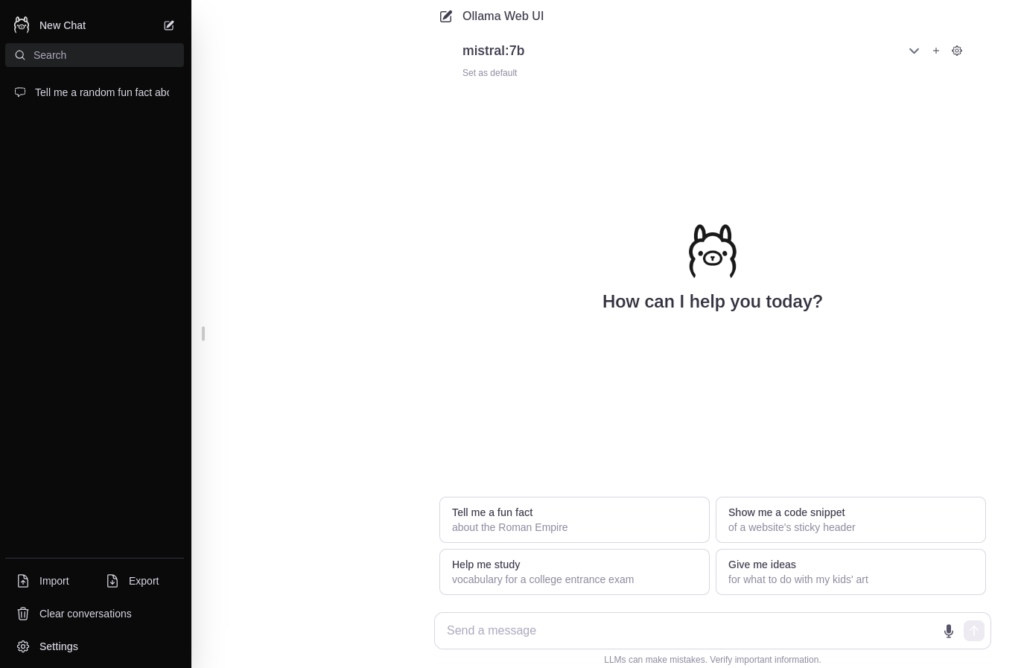

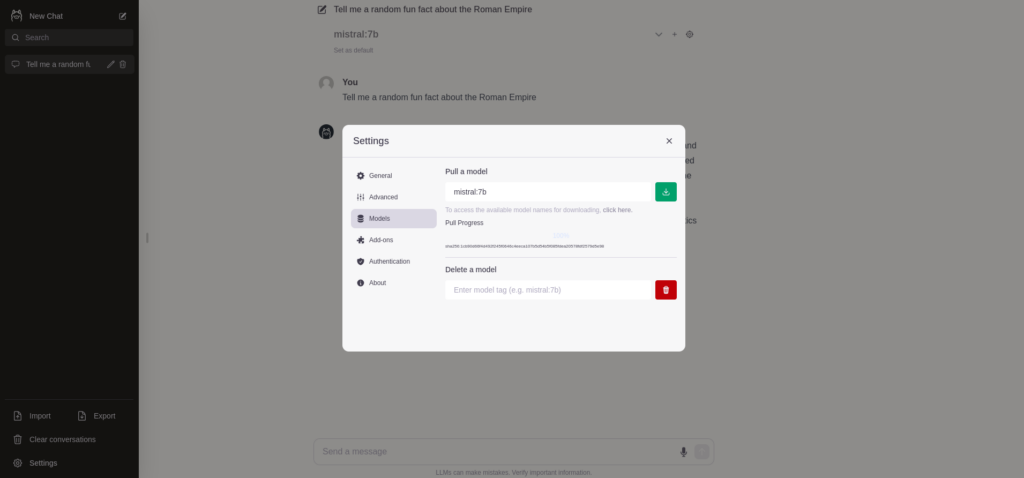

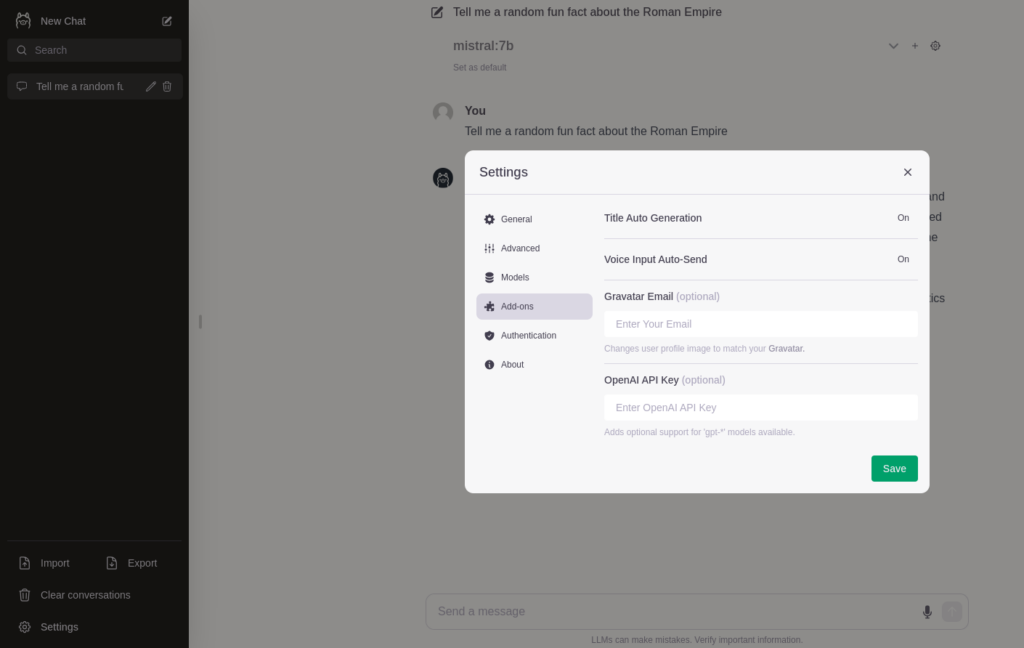

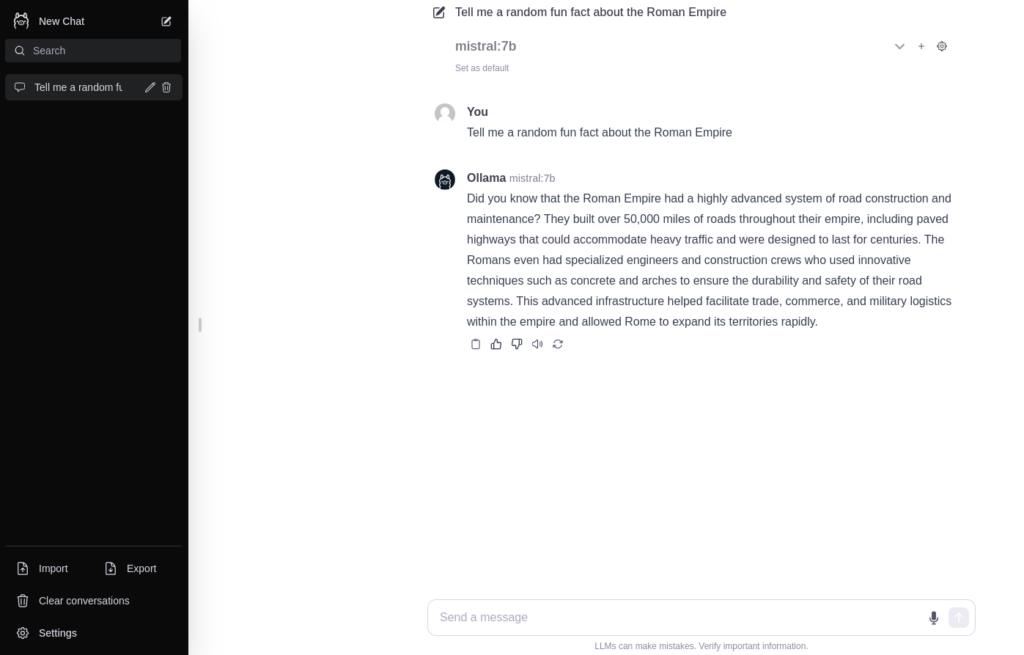

⏩ Ollama Open UI : discutez par écrit et oralement avec des LLM open source de manière sécurisée [Discussion] [Document] [LLM open source]🆕

⏩ h2ogpt : Analysez et résumez vos documents ou discutez avec des LLM privés locaux depuis votre ordinateur [Discussion] [Document] [LLM open source]

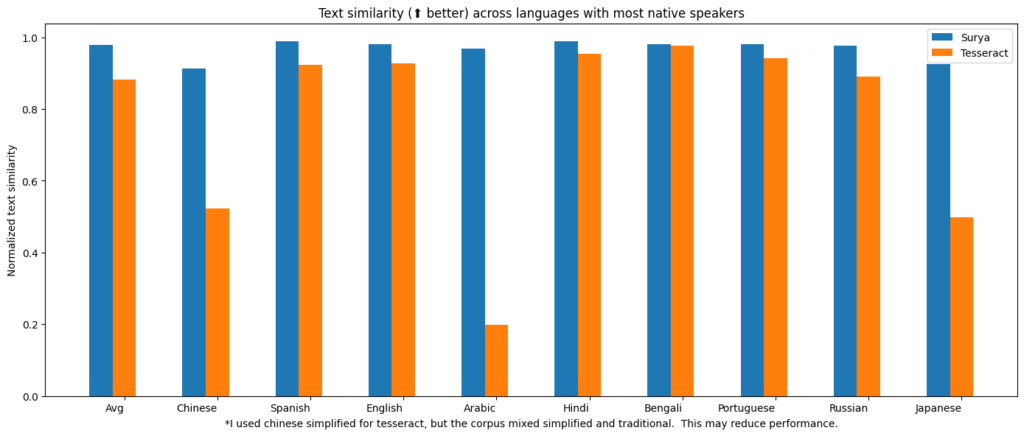

⏩ Surya – OCR de documents multilingues – reconnaissance de texte depuis un document pdf image ou une image [Reconnaissance de caractères]🆕

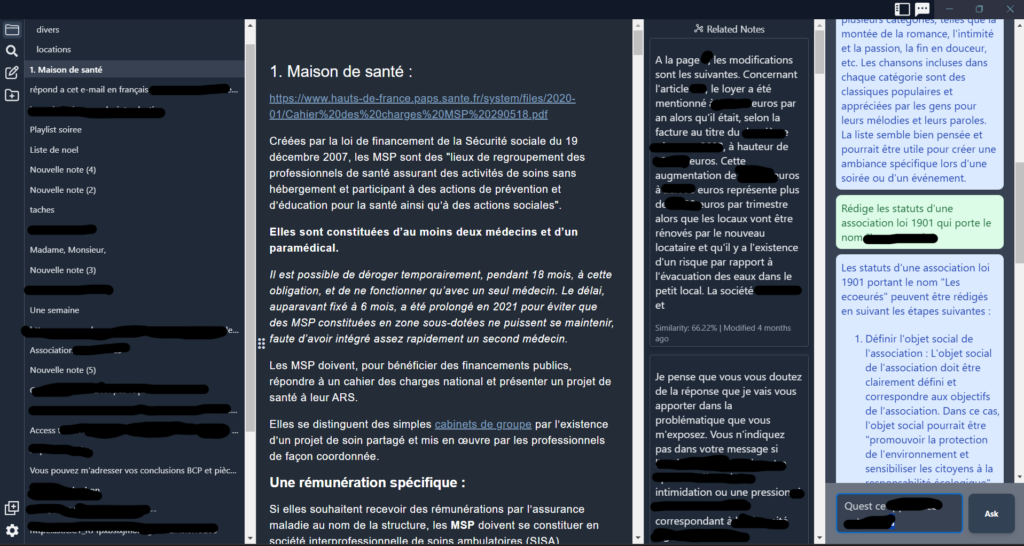

⏩ Reor : organisation de vos notes et obtention de réponses sur vos notes avec l’intelligence artificielle [Discussion] [Notes] [LLM open source] 🆕

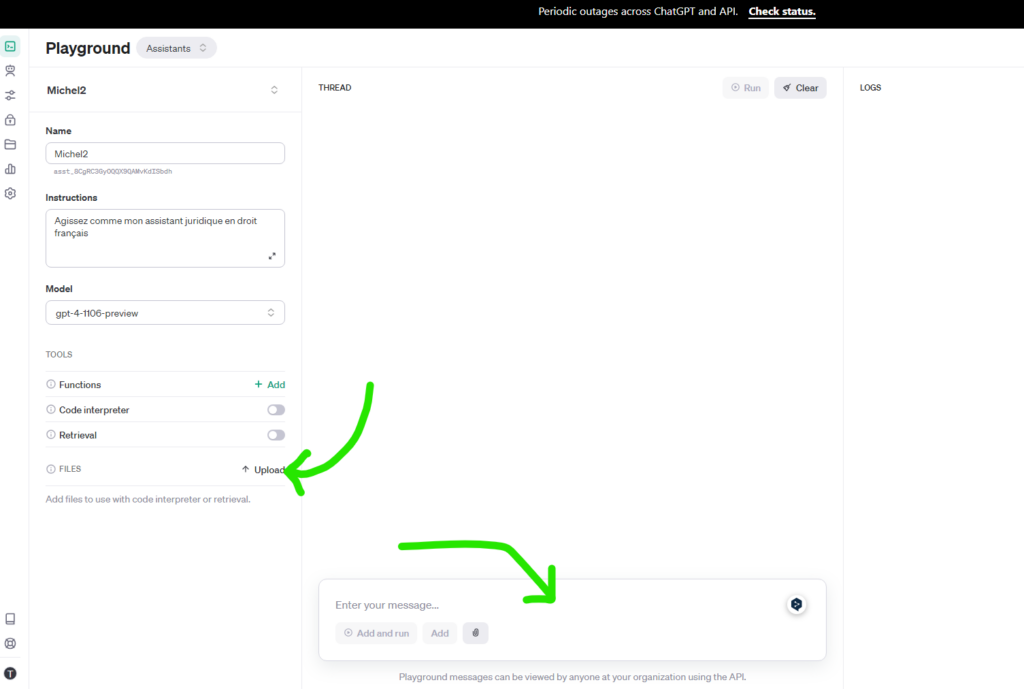

⏩ GPT4 Builder : créez un assistant d’intelligence artificielle personnalisé depuis la plateforme développeurs de OpenAI [Discussion] [Document] [OpenAI]

⏩ Exemples de prompts pour mieux utiliser les logiciels d’intelligence artificielle [prompts]

Date de mise à jour : 30 mars 2024 | Auteur : Timo RAINIO

Introduction – Avant propos…

Il existe déjà de nombreux sites internet permettant d’utiliser des logiciels d’intelligence artificielle commerciaux et modèles de langages propriétaires.

La principale problématique de tous ces sites et logiciels commerciaux réside dans le respect de la confidentialité des données communiquées. Même si la société OpenAI a déclaré qu’elle n’entraînait plus ses modèles sur les données des utilisateurs via ses API (ou sur option si vous utilisez son site internet dédié: https://chat.openai.com/chat ), ces données sont tout de même transmises à une société américaine, domiciliée aux Etats Unis d’Amérique, avec la réglementation que l’on connait du Foreign Intelligence Surveillance Act qui autorise les administrations américaines à collecter toutes les données détenues par les sociétés ou personnes morales de droit américain. Enfin, comment prouver que la société OpenAI n’utilise effectivement plus les données des utilisateurs pour entraîner ses modèles ? Il s’agit d’une preuve par la négative quasi impossible à rapporter…

.. L’anonymisation des données reste donc recommandée lorsqu’on utilise ces logiciels d’intelligence artificielle commerciaux tels que ceux de la société OpenAI, de Microsoft Bing ou Copilot, de Google Bard, ou Claude de la société Anthropic …etc..

📲 Désormais, les logiciels d’intelligence artificielle peuvent être installés presque partout : sur votre ordinateur personnel, sur votre smartphone / iphone, dans votre voiture, et demain peut-être dans la paume de votre main .

Toutefois, l’intérêt d’installer et d’utiliser un logiciel d’intelligence artificielle open source, sur votre ordinateur, sur votre serveur interne à votre entreprise, sur votre VPS, ou sur un serveur dédié, est de reprendre (un peu) le contrôle de vos données et celles de vos clients qui vous font confiance.

Avec ce type de logiciel open source, vous pourrez envoyer des prompts avec des données personnelles, partager, confidentiellement, les recherches effectuées et les résultats obtenus via un compte utilisateur commun, avec certains collaborateurs de votre entreprise ou de votre cabinet d’avocats….

Vous pouvez également utiliser et former un logiciel d’intelligence artificielle open source, avec vos propres données en restant ‘propriétaire’ de celles-ci… et sans devoir les envoyer sur les serveurs cloud des sociétés commerciales telles que OpenAI, Microsoft ou Google, sociétés (via leur ‘API’) qui pourront les revendre, par exemple, à des courtiers en données personnelles, et/ou les utiliser pour former leur modèles (…et vous remplacer par l’intelligence artificielle plus rapidement que prévu… 😉 ).

.Actuellement, les sites internet, plateformes services et/ou outils d’intelligence artificielle commerciaux et open source se développent très rapidement. A tel point qu’il est difficile de tous les lister au fur et à mesure.

Il est possible que dans les prochaines années (ou quelques mois ?…), on assiste à une spécialisation ou personnalisation des AI, avec certains sites internet et/ou outils qui se démarqueront des autres pour certaines fonctions bien précises.

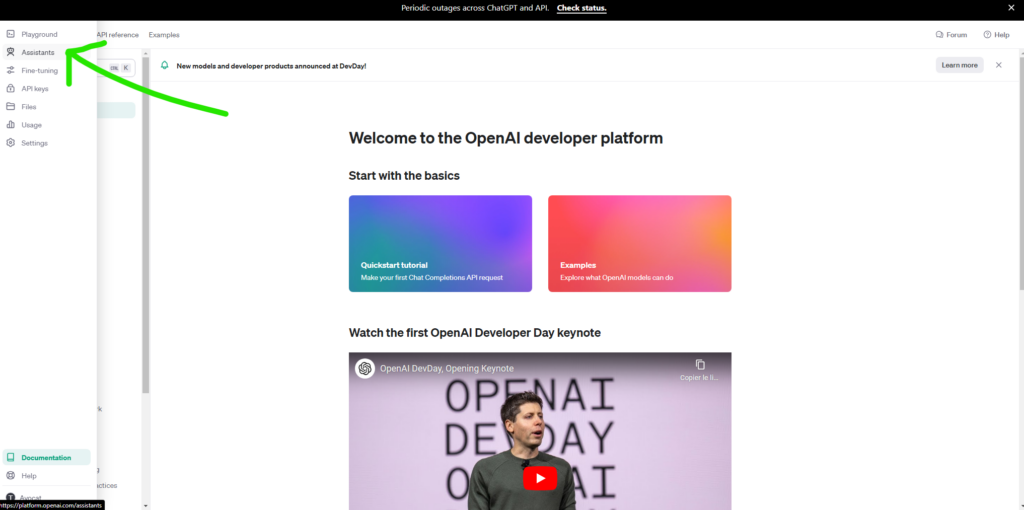

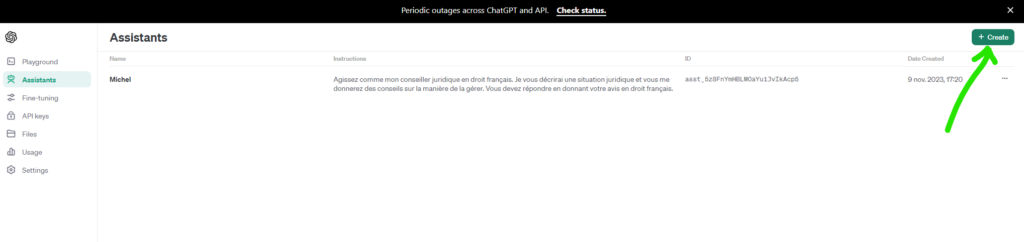

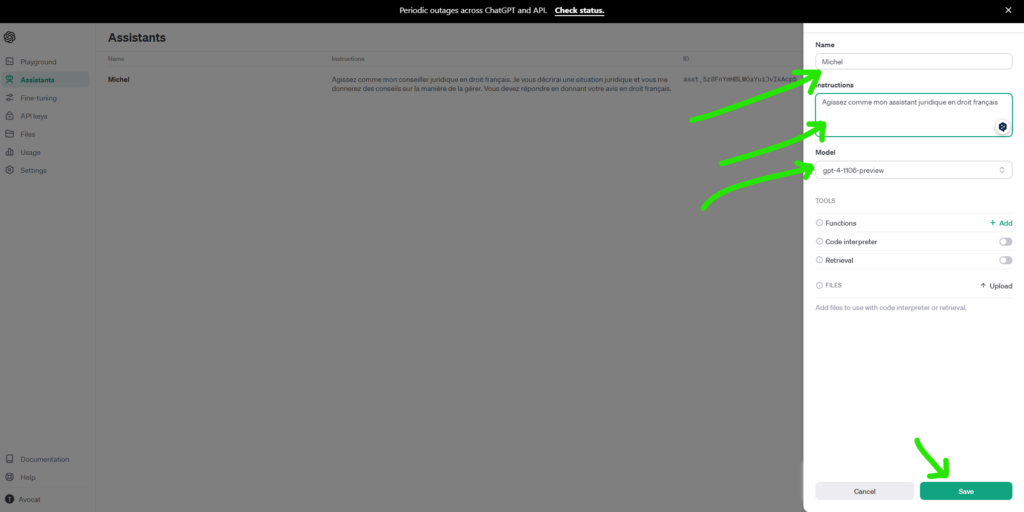

Ainsi, le 6 novembre 2023, la société OpenAI a mis en place une plateforme pour créer ses propres assistants intelligence artificielle personnalisés et basés sur une nouvelle version de GPT4. Cette possibilité de créer ses propres assistants intelligence artificielle personnalisés basés sur GPT4 nous questionne sur l’intérêt d’héberger sur son serveur des logiciels open source tel que LibreChat, OP Vault ou DocsMind, logiciels aux fonctionnalités globalement similaires…

Par contre, cela ne change rien sur l’intérêt d’héberger ses propres logiciels d’intelligence artificielle open source basés sur les modèles de langages Llama2, MistralAI, Falcon… etc. pour des raisons évidente de confidentialité des données soumises à ces logiciels.

De manière plus générale, on voit apparaître des logiciels d’intelligence artificielle open source impressionnants pour le ‘grand public’, à titre d’exemples :

- Un logiciel pour se connecter sur internet, faire des recherches et véritablement ‘visualiser’ et retranscrire les images affichées sur des sites web :

- Un logiciel pour intégrer des objets virtuels sur d’une photographie :

- …et d’autres logiciels qui me semblent inquiétants sur le plan du respect de la vie privée et des infractions possibles… selon leur utilisation… tel que certains logiciels pour cloner des voix humaines (ou VoiceCraft ou OpenVoice)

- ou d’autres logiciels d’intelligence artificielle ‘grand public‘ permettant retranscrire en texte ce qui apparaît sur des images capturées en temps réel dans la rue…

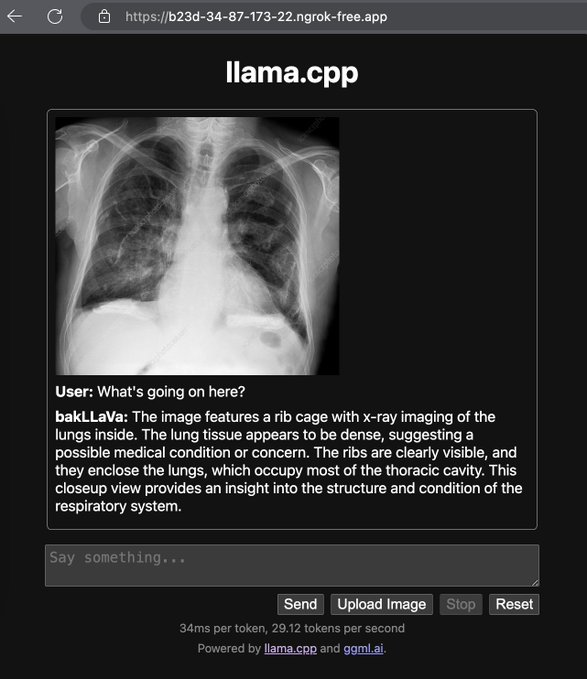

ou des logiciels d’intelligence artificielle avec des finalités utiles et bienveillantes pour l’humanité permettant, par exemple, l’analyse d’images médicales pour aider les médecins à mieux repérer des cancers :

Bref, il est très intéressant de suivre l’évolution de l’intégration dans la société ces différents logiciels d’intelligence artificielle …

- Va-t-on aller vers un monde dystopique, plus ou moins contrôlé par différents logiciels d’intelligence artificielle de grandes sociétés commerciales ou par des Etats (Chine, Etats Unis d’Amérique…), dans lequel nous devrons adapter quotidiennement notre comportement et nos actions en fonction du fonctionnement un peu obscur de ces logiciels d’intelligence artificielles. Voir par exemple, actuellement ou dans un très prochain futur, les logiciels d’intelligence artificielle analyser les réponses des candidats lors des entretiens d’embauche : https://lablab.ai/event/monday-ai-app-hackathon/ai-rebel/autorecruit ; ou pour les entretiens psychologiques : https://lablab.ai/event/eleven-labs-ai-hackathon/mentalsync/mentalsync ; ou très probablement pour l’obtention de prêt bancaires pour les primo accédants à la propriété immobilière…

Bref, un monde horrible ou nous deviendrons tous plus ou moins des psychopathes atteints de trouble dissociatif de l’identité, afin de s’adapter aux attentes, supposées ou réelles, des logiciels d’intelligence artificielle et des personnes ‘idiotes’ les utilisant…) ;

- Ou va-t-on aller vers un monde dans lequel les logiciels d’intelligence artificielle ne seront finalement qu’un support technique supplémentaire pour nous, un peu comme le sont devenus les moteurs de recherche sur internet aujourd’hui (Google …). L’humain gardant alors toute sa place ;

- Ou va-t-on aller vers un monde dans lequel les futurs logiciels atteindront rapidement un niveau d’intelligence artificielle générale et pourront faire preuve d’une réelle ‘créativité’ similaire ou supérieure à celle de l’être humain … et où soit les disparités seront finalement exacerbées entre les sachant (riches en général) et les autres, ou soit au contraire, un monde dans lequel ces logiciels d’intelligence artificielle générale nous permettront de maintenir un niveau de vie elevé pour le maximum de personnes, en répartissant un peu mieux et gaspillant un peu moins les ressources naturelles … (sommes-nous d’ailleurs actuellement dans une simulation informatique ? 😉) ;

- Ou va-ton aller vers un monde multipolaire en matière de logiciels d’intelligence artificielle avec des sociétés et Etats ayant des utilisations, conceptions et des approches radicalement différentes de la création et de l’utilisation des logiciels d’intelligence artificielle , et à moyen terme, potentiellement des conflits violents de conception de sociétés comme actuellement entre les religions mais appliqué aux intelligences artificielles…

Ou vers un monde de plus en plus complexe qui mêle les problématiques citées ci-dessus et bien d’autres…

Ceci étant, en attendant ces potentiels futurs réjouissants pour l’humanité (…), nous avons listé certains sites internet et outils d’intelligence artificielle qui sans pour autant être ‘effrayants’ (ou créer des maux de têtes par rapport à des possibilités que nous ne pouvons pas contrôler), sont actuellement susceptibles d’améliorer votre productivité.

Nous proposons également des tutoriels pour installer les équivalents de certains de ces logiciels et sites web commerciaux, mais en open source et en auto hébergé, c’est à dire installé sur votre ordinateur sous linux, votre serveur ou sur un VPS, afin de mieux sécuriser vos données lorsque vous utilisez ce type de logiciels d’intelligence artificielle, pour votre entreprise ou cabinet d’avocats.

QUELQUES OUTILS D’INTELLIGENCE ARTIFICIELLE (GRATUITS) POUR LE TRAVAIL QUOTIDIEN + LA PRODUCTIVITÉ :

Tous ces outils peuvent être utilisés gratuitement sous réserve d’anonymiser les données…, bien que la plupart d’entre eux proposent une sorte d’offre premium si vous avez besoin de fonctionnalités plus avancées ou d’une tonne de requêtes.

▶️ ChatPDF : Outil gratuit pour utiliser ChatGPT sur vos propres documents/PDF

En termes simples, ChatPDF vous permet de télécharger n’importe quel PDF et d’interagir avec lui comme ChatGPT. Certains élèves l’utilisent pour générer automatiquement des flashcards et expliquer des concepts basés sur des notes de cours et des lectures. Il existe quelques services similaires, mais ChatPDF est le plus simple à utiliser parmi ceux qui ne nécessitent pas de paiement/d’inscription.

Principales caractéristiques :

- Gratuit pour télécharger jusqu’à 3 PDF par jour, avec jusqu’à 120 pages dans chaque PDF

- Peut être utilisé sans aucune inscription

▶️ Taskade : Outil de gestion, de planification et de prise de notes des tâches d’IA avec GPT-4 intégré (gratuit avec inscription)

Taskade est une plateforme tout-en-un de prise de notes, de gestion des tâches et de planification avec des flux de travail et des modèles d’IA intégrés. Comme Notion (ou comme AppFlowy si vous souhaitez utiliser la version de Notion ‘open source’ et respectueuse de vos données et de celles de vos clients : https://github.com/AppFlowy-IO/AppFlowy) , Taskade vous permet de créer facilement des espaces de travail, des documents et des modèles pour vos flux de travail. Contrairement à l’IA basée sur GPT-3 de Notion, Taskade intègre une IA basée sur GPT-4 qui est formée pour structurer vos documents, créer du contenu et vous aider à améliorer votre productivité.

Principales caractéristiques :

- GPT-4 est intégré à leur plan gratuit et formé pour aider au formatage des documents, à la planification, à la création de contenu et à la réponse aux questions via une interface de chat. Son IA semble spécifiquement formée pour fonctionner de manière transparente avec vos documents et espaces de travail, et comprend les requêtes spécifiques à leur interface, comme lui demander de transformer des notes (textuelles) en une carte mentale.

- L’une des limites d’utilisation les plus élevées des outils gratuits : le plan gratuit de Taskade comprend 1 000 requêtes mensuelles, ce qui est l’une des limites d’utilisation les plus élevées que vues pour un outil avec GPT-4 intégré.

- Parce qu’il est intégré à un éditeur de documents doté de fonctionnalités de base de données, de planification et de chat, vous pouvez l’utiliser pour à peu près tout ce pour quoi vous utiliseriez ChatGPT, mais sans payer pour ChatGPT Premium.

- Modèles gratuits pour vous aider à réellement intégrer l’IA dans vos flux de travail : il existe un grand nombre de modèles gratuits véritablement utiles pour les flux de travail, la gestion des tâches, la cartographie mentale, etc.

- Par exemple, vous pouvez ajouter un projet et demander à Taskade de le cartographier et de le créer automatiquement. planifier une répartition des tâches qui composent ce livrable global.

.▶️ Plus AI for Google Slides : Diaporamas générés (et améliorés) par l’IA (gratuit avec inscription, module complémentaire pour Google Slides)

+ AI est un module complémentaire (gratuit !) de Google Slides qui vous permet de décrire le type de diaporama que vous créez, puis de le générer et de l’affiner en fonction de vos besoins exacts.

Nous n’en sommes toujours pas au point où vous pouvez littéralement lui donner une seule invite et obtenir l’intégralité du produit fini, mais cela vous fait gagner beaucoup de temps en créant une structure initiale que vous pouvez ensuite perfectionner. De même, si vous avez créé des diapositives existantes, vous pouvez lui indiquer (en langage naturel) comment vous souhaitez qu’elles soient modifiées.

Par exemple, lui demander de modifier la disposition du texte sur une page, d’améliorer le style d’écriture ou encore d’utiliser des sources de données externes.

Principales caractéristiques :

- S’intègre parfaitement à Google Slides : si vous utilisez déjà Slides, utiliser Plus AI est aussi simple que d’installer le plugin. Leurs didacticiels sont faciles à suivre et ne nécessitent pas l’apprentissage d’un nouveau logiciel ou d’une nouvelle interface de diaporama comme certaines autres options.

- Créez et modifiez des diapositives en langage naturel : De plus, l’IA vous permet de créer des diaporamas entiers, d’ajuster le texte ou de modifier les mises en page en langage naturel. Tout cela est assez intuitif et constitue le meilleur des outils de diapositives IA que j’ai essayés.

▶️ FlowGPT : Base de données d’invites et de flux de travail d’IA (gratuit sans inscription, même si cela vous pousse à vous inscrire !)

FlowGPT collecte des invites et des collections d’invites pour effectuer diverses tâches, du marketing à la productivité en passant par le codage, ainsi que des éléments aléatoires que les gens trouvent intéressants. Il utilise un système de vote positif similaire à Reddit qui permet de trouver facilement des façons intéressantes d’utiliser ChatGPT. Il vous permet également de rechercher des invites si vous avez quelque chose en tête et souhaitez voir ce que les autres ont fait. C’est gratuit et propose de nombreuses fonctionnalités intéressantes, telles que l’affichage d’un aperçu de la façon dont ChatGPT répond aux invites.

▶️ Summarize.Tech : Résumés IA des vidéos YouTube (gratuit sans inscription)

Summarize génère des résumés IA de vidéos YouTube, les condensant en notes écrites relativement courtes avec horodatages.

▶️ Claude : Alternative ChatGPT avec une limite de ~ 75 000 mots (gratuit avec inscription)

Si vous avez utilisé ChatGPT, vous avez probablement rencontré le problème de sa limite (relativement faible) de jetons. En termes simples, il ne peut pas gérer un texte de plus de quelques milliers de mots. C’est la même raison pour laquelle ChatGPT « oublie » les instructions que vous lui avez données plus tôt dans une conversation. Claude résout ce problème avec une limite d’environ 75 000 mots qui vous permet de saisir des romans littéraux et de faire à peu près tout ce que vous pouvez faire avec ChatGPT. Malheureusement, Claude n’est actuellement gratuit qu’aux États-Unis ou au Royaume-Uni. IL faut donc utiiser un VPN Ou le site Poe : https://poe.com/ pour l’utiliser. Claude se présente comme l’IA « la plus sûre », ce qui peut rendre son utilisation difficile dans de nombreux cas d’utilisation, mais elle vaut la peine d’être essayée et est meilleure que ChatGPT pour certaines tâches.

Principales caractéristiques :

- Limite de mots beaucoup plus longue que même les modèles de jetons les plus élevés de ChatGPT

- Des garde-fous plus solides que ChatGPT : si vous aimez cela, Claude se concentre beaucoup plus sur « la confiance et la sécurité » que même ChatGPT.

▶️ Phind : Moteur de recherche IA qui combine Google avec ChatGPT (gratuit sans inscription)

Comme une combinaison de Google et ChatGPT. Comme ChatGPT, il peut comprendre des invites complexes et vous donner des réponses détaillées condensant plusieurs sources. Comme Google, il vous montre les sources les plus récentes répondant à votre question et a accès à tout sur Internet en temps réel (par rapport à la date limite de ChatGPT de septembre 2021). Contrairement à Google, il évite les liens spammés qui semblent dominer Google de nos jours et répond réellement à votre question.

Principales caractéristiques :

- Accède à Internet pour vous obtenir des informations en temps réel par rapport à la date limite de ChatGPT pour 2021. Bien que ChatGPT soit idéal pour la génération de contenu et d’autres tâches pour lesquelles vous n’avez pas vraiment besoin d’informations en direct, il ne peut vous fournir aucune information au-delà de son point limite.

- Fournit des sources réelles pour ses affirmations, vous aidant à approfondir des points spécifiques et à éviter les hallucinations. Phind a été le premier à combiner le meilleur des deux mondes entre Google et ChatGPT, vous donnant un accès facile aux sources réelles comme le fait Google tout en résumant les résultats pertinents comme le fait ChatGPT. C’est toujours l’un des meilleurs outil pour cela, surtout si vous avez des questions techniques.

▶️ Bing AI : Alternative ChatGPT basée sur GPT-4 (avec accès Internet)

Le chat AI de Bing est très similaire à ChatGPT (il est basé sur GPT-4). Contrairement au modèle de base de ChatGPT sans plugins, il a accès à Internet. Cela ne nécessite pas non plus de connexion, ce qui est bien.

Au risque de ressembler à un disque rayé, Google a vraiment laissé tomber la balle ces derniers temps en fournissant des résultats de recherche non spammés qui répondent réellement à la requête, et il est agréable de voir d’autres moteurs de recherche comme Bing et Phind proposer des alternatives.

Principales caractéristiques :

- Semblable à Phind, bien que sans doute un peu meilleur pour les questions non techniques : Bing fournit également des résumés de sources, génère du contenu et intègre par ailleurs bien l’IA et la recherche.

- Construit sur GPT-4 : comme Taskade, Bing a confirmé qu’il utilise GPT-4. Cela en fait une autre option intéressante pour contourner le paiement pour GPT-4 tout en bénéficiant des mêmes fonctionnalités que ChatGPT.

- Intégration transparente avec un moteur de recherche standard.

▶️ ZeroGPT : Site internet vous proposant d’analyser si un texte ou une partie de celui-ci a, potentiellement, été généré par un logiciel d’intelligence artifielle (OpenAI).

- Phrases surlignées : Chaque phrase écrite par l’IA est mise en évidence, avec une jauge indiquant le pourcentage d’IA dans le texte

- Téléchargement de fichiers par lots : Téléchargez simplement plusieurs fichiers à la fois et ils seront automatiquement vérifiés dans le tableau de bord.

- Rapport généré : Rapports .pdf générés automatiquement pour chaque détection

- Prise en charge de toutes les langues

AUTRES OUTILS D’IA GRATUITS QUI SONT PLUS SIMPLES OU N’ONT PAS BESOIN D’UNE EXPLICATION COMPLÈTE :

▶️ Remove.bg: Remove.bg utilise une IA simple pour supprimer les arrière-plans de vos images. C’est très simple, mais c’est quelque chose que je finis par faire étonnamment souvent en éditant des images de produits, etc.

▶️ CopyAI & Jasper : les deux sont des outils d’écriture d’IA principalement conçus pour le contenu de marketing de sites Web/de blogs. .

▶️ Gemini : Logiciel d’intelligence artificielle de la société Google Ltd

▶️ Consensus.app : Moteur de recherche qui utilise l’IA pour trouver des informations dans des articles de recherche.

▶️ Ordalie.tech : Site internet d’IA pour poser des questions sur le droit français – via Open AI Chat GPT

▶️ Legigpt : Site internet d’IA pour poser des questions le droit français – via Open AI Chat GPT et Legifrance.

▶️ Thegoodlegal : Site internet d’IA pour poser des questions le droit français, des fiches d’arrêts, synthétiser des documents – via Open AI Chat GPT.

▶️ Poe : Site internet permettant d’utiliser plusieurs AI, Chat GPT, Claude, Lllama2-70B…etc.

▶️ Perplexity : Moteur de recherche avec fonctionnalités d’IA, listant les sources – via Open AI.

▶️ OtterAI : Site internet permettant de résumer vos réunions en visioconférence – via Open AI Chat GPT.

▶️ SpellBook Legal : Site internet permettant d’analyser des contrats et documents légaux avec l’API de la société OpenAI.

Il existe également leurs ‘équivalents’ en logiciels open source se basant parfois sur les modèles de langage de la société Meta – Facebook LLaMA2, Falcon, Mistral AI, en mode ‘auto hébergé’ sur votre ordinateur ou serveur. Cela permet d’améliorer la confidentialité de vos données et celles de vos clients…

Les différents logiciels et services commerciaux utilisent les données des internautes, a minima pour permettre leur fonctionnement. Ces données, personnelles ou non, sont enregistrées sur les serveurs informatiques de ces sociétés commerciales, le plus souvent américaines. Cela peut interoger sur le respect de la confidentialité des données et on peut alors préférer utiliser un logiciel d’intelligence artificielle et modèle de langage open source, tel que Lllama2 ou MistralAI en interne…

ChatGPT pose-t-il des problèmes de confidentialité ? (Spoiler_Alert : oui )

https://www.makeuseof.com/chatgpt-privacy-issues/

Certes, au jour ou nous écrivons ces lignes, les modèles open source ne sont pas encore aussi performants que celui du ‘leader’, GPT4 de la société OpenAI et ils nécessitent souvent d’avoir un ordinateur puissant, disposant de beaucoup de mémoire RAM (minimum 16 Go).

Toutefois, ils se rapprochent de lui au fil des mois… Par exemple, il semble que le dernier modèle d’IA « Falcon-180B » sur Hugging-Face talonne désormais, en termes de performances, GPT4…. On constate également des améliorations régulières des différents modèles de langage des IA open source disponibles sur Hugging Face qui se spécialisent dans telle ou telle fonction (le codage informatique, la rédaction de textes, la discussion …etc. ).

Ainsi, afin de tenter de garder une certaine maîtrise de ces différents logiciels d’IA qui bouleversent nos méthodes de travail et conserver la confidentialité de nos données soumises à des logiciels d’IA, il nous semble important de connaitre et de savoir installer certains de logiciels open-sources actuels, qui se basent, actuellement, principalement sur les modèles d’IA de la société Meta – Facebook, (llama.cpp et LLAmA2) et Alpaca.

.

Liste des tutoriels :

Il est préférable d’avoir préalablement suivi les chapitres 1 à 3 du tutoriel d’installation de Juris-Tyr.

Introduction

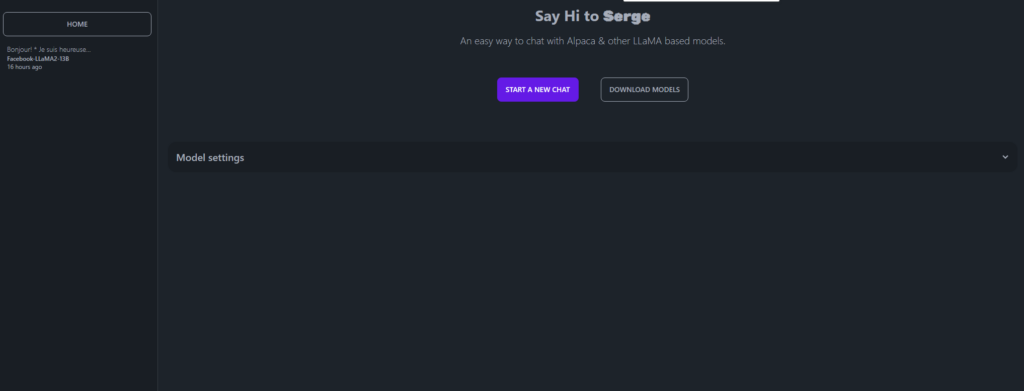

⏩ Serge, discutez avec des (AI) LLM open source

⏩ Ollama : accédez à Llama2, MistralAI et à d’autres LLM(s)

⏩ GodMode – AI Chat Browser, comparez les LLM entre eux

⏩ GPT4All, un logiciel à installer sur son PC sous Windows ou sur son Mac pour accéder à de nombreux (AI) LLM

⏩ LibreChat, un logiciel open source pour accéder à GPT4, Copliot, Claude, via leurs API

⏩ Web Whisper +, un logiciel de reconnaissance vocale et de traduction en ligne

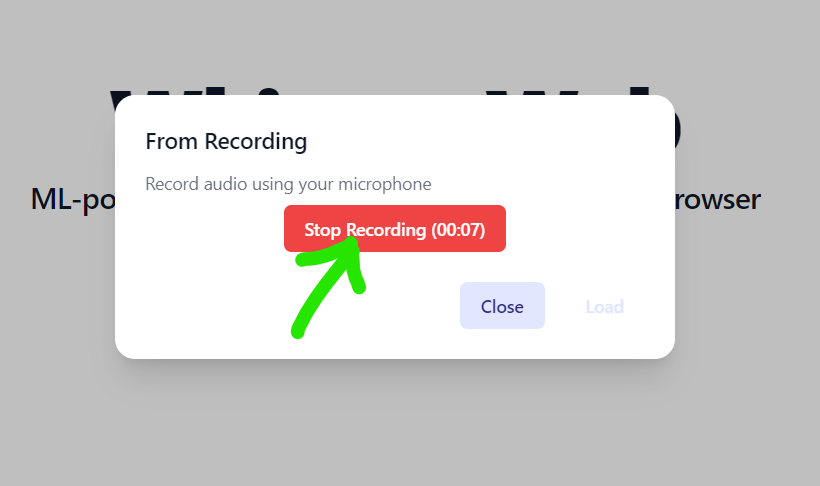

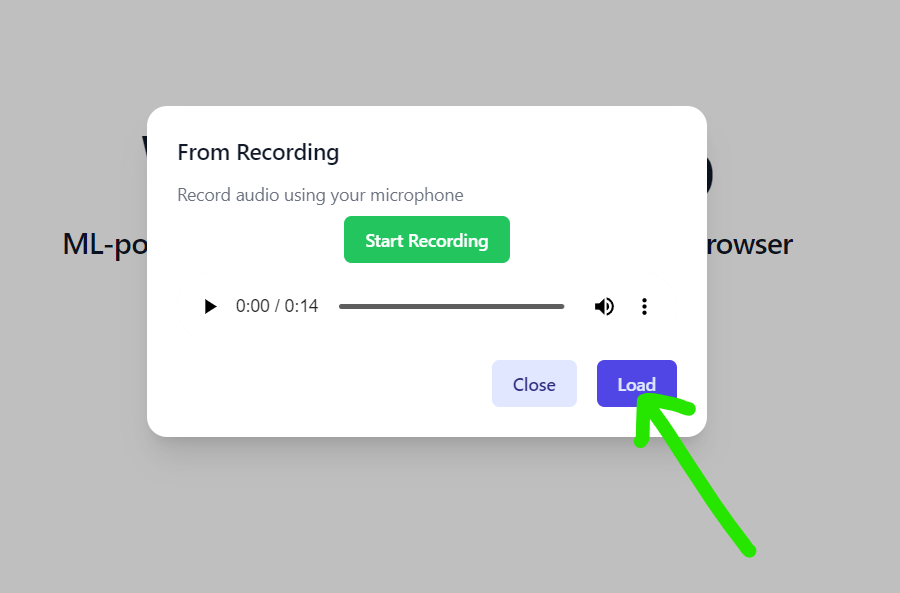

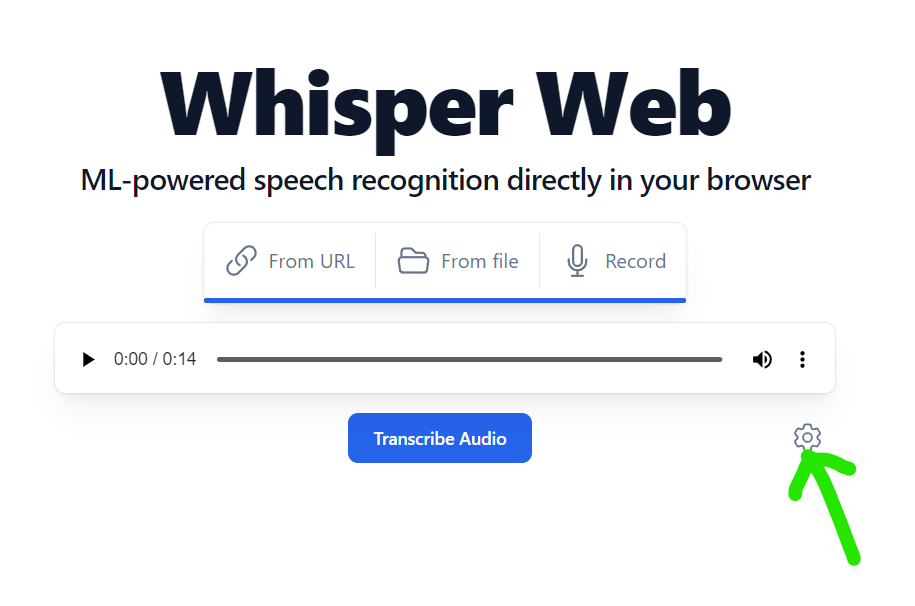

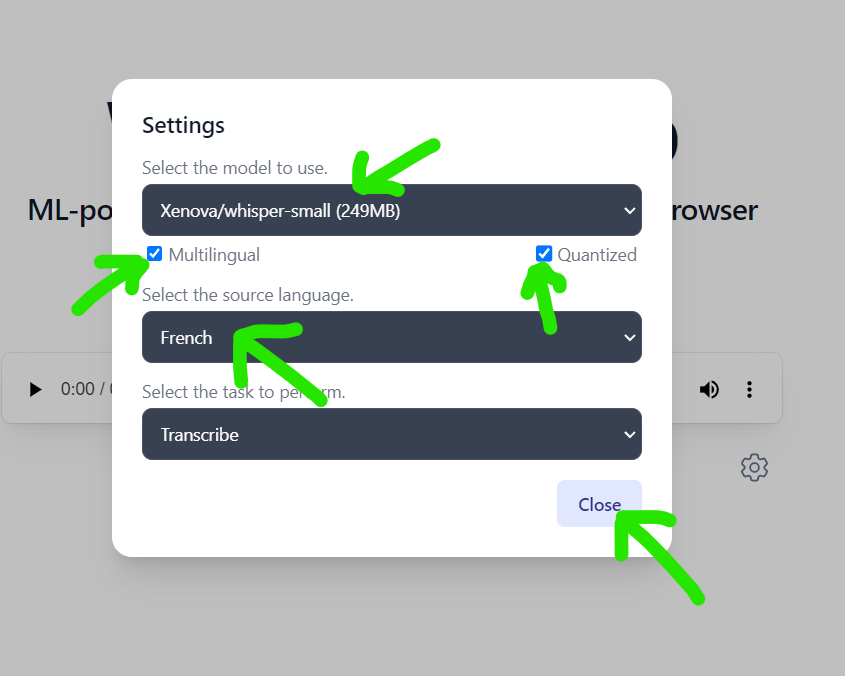

⏩ Whisper Web, un (autre) logiciel de reconnaissance vocale en ligne

⏩ Web-speech-synthesis-and-recognition un logiciel pour convertir la parole en texte et vice versa en quelques secondes,

⏩ OP Vault, discutez avec des documents PDF ou DOCX via l’API de GPT4

⏩ MultiPDF Chat App, discutez avec plusieurs documents PDF en même temps via l’API de GPT4

⏩ DocsMind, discutez avec un fichier PDF via l’API de GPT4

⏩ SecureAI Tools, discutez avec « MistralAI » et analysez vos fichiers PDF, de manière sécurisée et sans transmettre vos données à la société OpenAI

⏩ OllamaWebUI Tools, discutez par écrit et oralement avec le LLM « MistralAI » de manière sécurisée et sans transmettre de données à OpenAI

⏩ h2ogpt : Analysez et résumez vos documents ou discutez simplement avec des LLM GPT privés locaux depuis votre PC sous Windows ou votre Mac

⏩ BionicGPT, discutez avec le LLM « Llama2 » , analyser et résumer vos documents en local, de manière sécurisée, confidentielle

⏩ GPT4 Builder, créez un assistant d’intelligence artificielle personnalisé sur le LLM GPT4 en utilisant une API depuis la plateforme développeurs d’ OpenAI

⏩ Exemples de prompts pour mieux utiliser les logiciels d’intelligence artificielle

Serge, un logiciel pour discuter avec des (AI) LLM open source

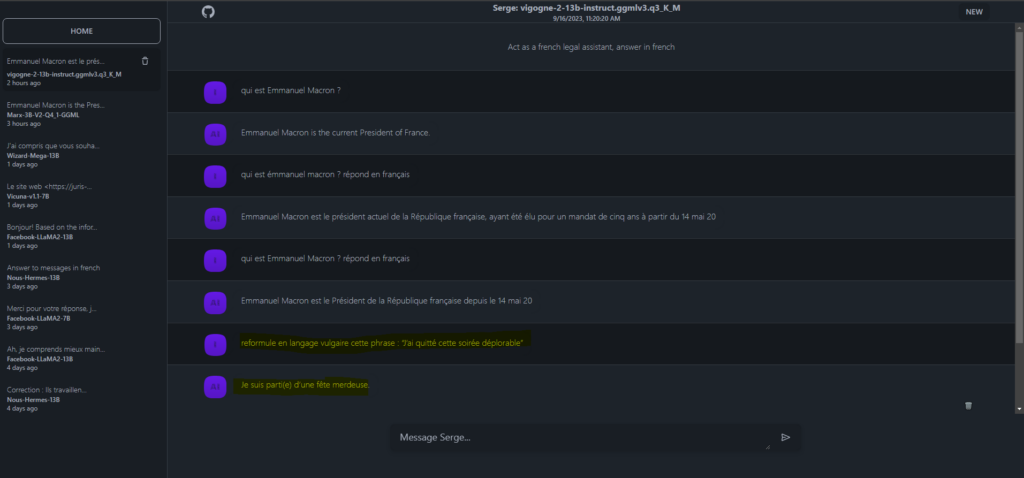

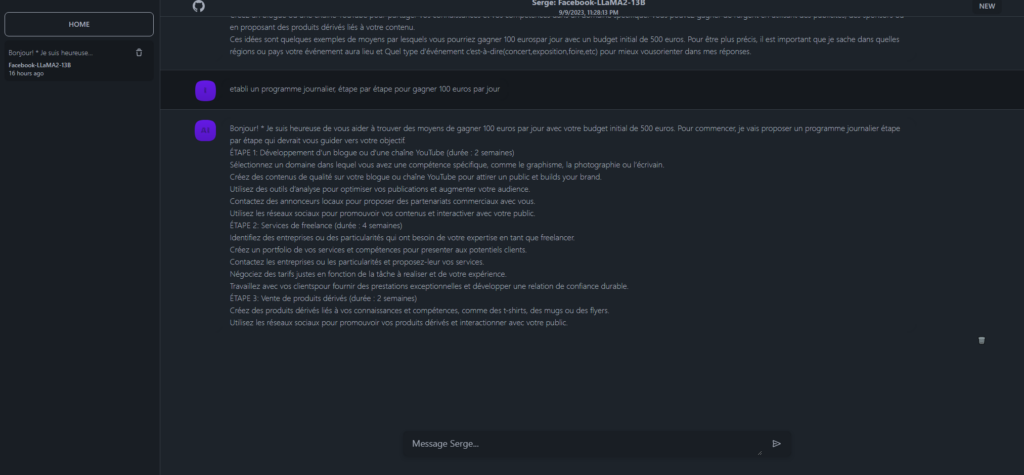

L’application open-source « Serge » est une interface de chat conçue avec llama.cpp pour exécuter des modèles open-sources Alpaca (Llama2). Il n’y a pas de clé API requise, le logiciel fonctionne entièrement auto-hébergé et il est régulièrement mis à jour.

Avec cette application, aucune de vos données ne sera envoyée sur les serveurs de la société OpenAI, de Microsoft ou de tout autre société commerciale. L’inconvénient est que son installation est un peu complexe….

Caractéristiques :

🌐 Interface SvelteKit

💾 Redis pour stocker l’historique et les paramètres des discussions

⚙️ FastAPI + LangChain pour l’API, encapsulant les prompt vers llama.cpp à l’aide des liaisons python

Vous pouvez télécharger cette application depuis ce dépôt sur Github : https://github.com/serge-chat/serge

Attention ! Pour fonctionner correctement (sans que vous ayez l’impression que le temps s’est subitement arrété…), Serge nécessite que votre ordinateur ou votre serveur/VPS dispose de suffisamment de mémoire RAM (minimum 16 Go recommandé pour des modèles de LLM 13B).

Si votre ordinateur ou votre serveur ne dispose que de 4 ou 8 Go de mémoire RAM, nous vous recommandons de privilégier l’installation de LibreChat.

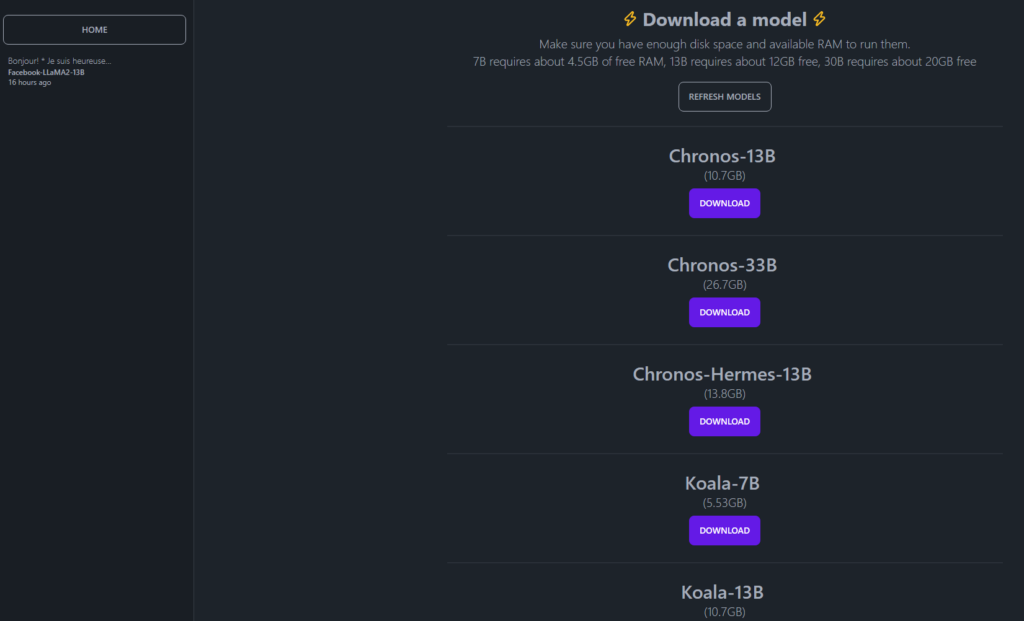

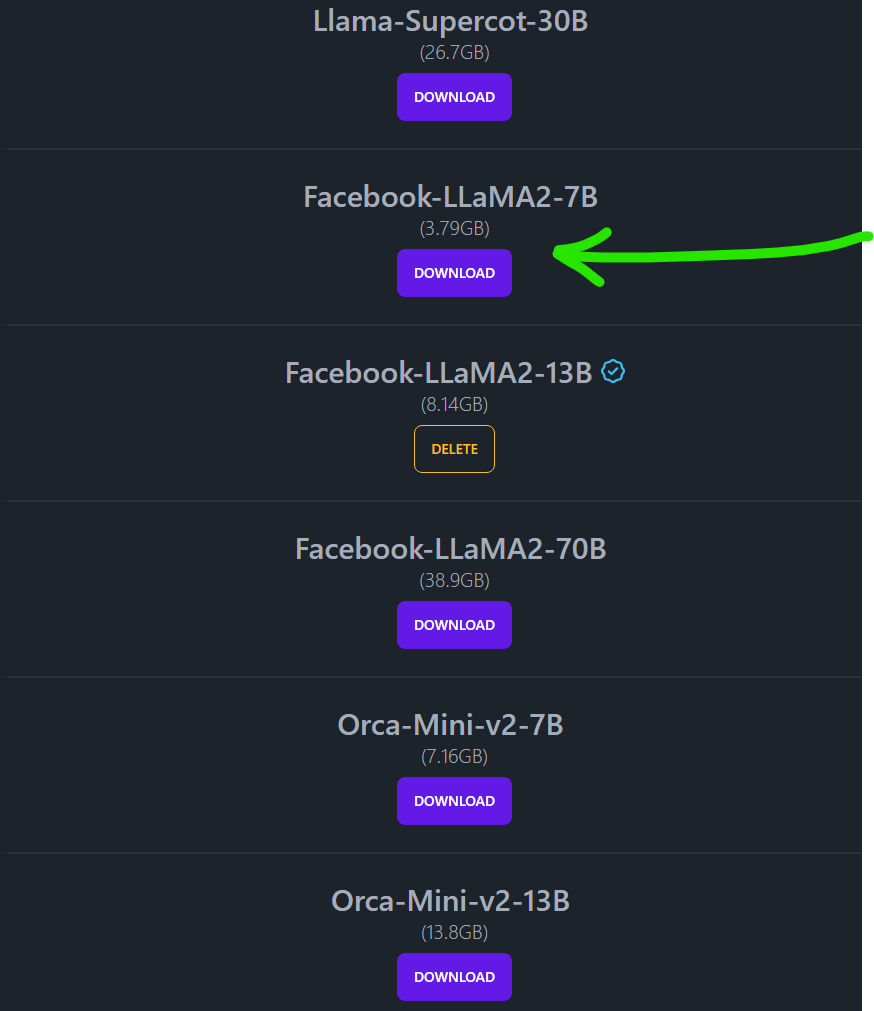

Serge permet de faire tourner de nombreux models de langages :

- MistralAI

- Facebook-LLaMA2-7B (3.79GB)

- …etc.

Après quelques essais, les modèles fournis de base les plus efficaces (ou les moins mauvais…) pour envoyer des prompts en langue française nous semblent être ceux de Mistral et Facebook-LLaMA2-13B, Par contre, selon la taille du modèle de langage (7B, 13B…) et la mémoire RAM disponible sur l’ordinateur serveur, les performances seront plus ou moins bonnes…

Il est possible de télécharger des modèles de langages plus légers et adaptés à la langue française. C’est ce que nous allons faire après dans ce tutoriel

Pour installer ce logiciel, il est préférable d’avoir préalablement suivi les chapitres 1 à 3 du tutoriel d’installation de Juris-Tyr.

Etape 1 : Installez les progiciels nécessaires :

Installez les progiciels nécessaires (s’ils ne sont pas déjà installés) :

Exécutez en premier la commande suivante pour vérifier et installer les mise à jour :

sudo apt update

sudo apt upgrade

Installez apache2 :

sudo apt install -y apache2 apache2-utils

sudo systemctl start apache2

sudo systemctl enable apache2

sudo iptables -I INPUT -p tcp --dport 80 -j ACCEPT

sudo iptables -I INPUT -p tcp --dport 443 -j ACCEPT

Créez un fichier de configuration servername.conf :

sudo nano /etc/apache2/conf-available/servername.conf

Ajoutez dans le fichier /etc/apache2/conf-available/servername.conf la ligne suivante :

ServerName localhostEnregistrez et fermez le fichier : Pour enregistrer un fichier dans l’éditeur de texte « Nano », appuyez sur les touches Ctrl + O (pour ‘Oui’) ou sur Ctrl + Y (pour ‘Yes), puis appuyez sur Entrée pour confirmer.

Pour quitter l’éditeur de texte ‘Nano’, appuyez sur les touches : Ctrl + X.

Activez ensuite ce fichier de configuration sous le serveur Apache avec la commande suivante :

sudo a2enconf servername.conf

Rechargez Apache pour que la modification prenne effet :

sudo systemctl reload apache2

Installez Docker :

sudo apt-get update

sudo apt-get install ca-certificates curl

sudo install -m 0755 -d /etc/apt/keyrings

sudo curl -fsSL https://download.docker.com/linux/ubuntu/gpg -o /etc/apt/keyrings/docker.asc

sudo chmod a+r /etc/apt/keyrings/docker.asc

echo \

"deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.asc] https://download.docker.com/linux/ubuntu \

$(. /etc/os-release && echo "$VERSION_CODENAME") stable" | \

sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

sudo apt-get update

sudo apt-get install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

Installez Docker Compose :

Docker Compose est un outil qui permet de configurer facilement des applications ou des services complexe composés de divers conteneurs. Pour installer Docker Compose sur votre système Ubuntu, téléchargez la version la plus récente (à partir du site officiel) et exécutez la commande suivante:

sudo curl -L « https://github.com/docker/compose/releases/download/1.26.2/docker-compose-$(uname -s)-$(uname -m) » -o /usr/local/bin/docker-compose

sudo apt-get install docker-compose-plugin

Après avoir installé Docker Compose, donnez-lui les autorisations nécessaires pour qu’elle puisse être exécutée correctement:

sudo chmod +x /usr/local/bin/docker-compose

Une fois l ‘installation terminée, vous pouvez exécuter le service Docker sur votre système en exécutant la commande :

sudo systemctl start docker

sudo systemctl enable docker

Installez Conda /miniconda :

sudo wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

Ou si vous avez un Raspberry 4 ou 5 ou un OrangePi 5, executez la commande suivante :

sudo wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-aarch64.sh

Puis, exécutez la commande suivante :

sudo bash Miniconda3-latest-Linux-x86_64.sh

Ou si vous avez un Raspberry 4 ou 5 ou un OrangePi 5, executez la commande suivante :

sudo bash Miniconda3-latest-Linux-aarch64.sh

Installez Yarn :

sudo npm install --global yarn

Installez git :

sudo apt install git

Installez FFmpeg :

sudo apt install ffmpeg

Installez Python :

sudo apt update

sudo apt install build-essential zlib1g-dev libncurses5-dev libgdbm-dev libnss3-dev libssl-dev libreadline-dev libffi-dev libsqlite3-dev wget libbz2-dev

sudo wget https://www.python.org/ftp/python/3.11.3/Python-3.11.3.tgz

sudo tar -xf Python-3.11.3.tgz

cd Python-3.11.3

sudo ./configure --enable-optimizations

sudo make -j 12

sudo make altinstall

Si vous avez une carte graphique Nvidia Rtx, installez Cuda :

sudo su

wget https://developer.download.nvidia.com/compute/cuda/12.4.0/local_installers/cuda_12.4.0_550.54.14_linux.runsudo sh cuda_12.4.0_550.54.14_linux.run

Installer Node.js et NPM :

sudo apt update

sudo apt-get install nodejs

sudo apt install build-essential

sudo apt install npm

1.1. Installez les autres progiciels nécessaires :

S’ils ne sont pas déjà installés, installez les logiciels Python3.

Exécutez les commandes suivantes :

#installer python3

sudo apt-get install libffi-dev libssl-dev

sudo apt install python3-dev

sudo apt-get install -y python3 python3-pip

sudo pip3 install docker-compose

sudo apt-get install docker-compose-plugin

Etape 2 : Installer le conteneur Docker « Serge » depuis Github

Exécutez la commande suivante :

sudo apt install git

Exécutez la commande suivante :

sudo docker run -d \ --name serge \ -v weights:/usr/src/app/weights \ -v datadb:/data/db/ \ -p 8008:8008 \ ghcr.io/serge-chat/serge:latest

Désormais si vous tapez l’adresse http://localhost:8008 dans la barre d’adresse du navigateur internet de votre ordinateur ou de votre serveur, vous accéderez à l’interface de Serge :

Cependant, si vous avez installé Serge sur un VP ou si vous souhaitez pouvoir accéder à ce logiciel d’intelligence artificielle depuis votre villa à l’île-Maurice… via un site internet avec une adresse ressemblant à http://serge.exemple.com ou à http://ia exemple.com, nous allons donc devoir créer un accès à ce conteneur Docker depuis un site internet en configurant un fichier ‘Virtualhost’ sur un serveur Apache.

Attention toutes les personnes qui connaîtront cette adresse web pourront accéder à votre instance de Serge. Il sera donc préférable de supprimer vos discussions après l’avoir utilisé.

Etape 3 : Créez un ficher Virtualhost pour un serveur apache (facultatif)

3.1. Créez un fichier de configuration apache

Si vous avez installé cette application sur un serveur VPS, vous ne pourrez pas vous connecter avec votre navigateur à l’adresse locale : http://localhost:8008 ou à l’adresse http://192.168.1.XX:8008 du VPS.

Il faut alors créer un accès vers cette application depuis un site internet spécifique.

Pour accéder à ce logiciel d’intelligence artificielle ‘Serge’ depuis un site internet, vous devez d’abord créer un sous-domaine : « ia.exemple.com » ou « serge.exemple .com » depuis votre compte client de votre gestionnaire de domaine en le reliant à l’adresse IP de votre serveur via un enregistrement ‘DNS A’.

Si vous ne vous vous souvenez plus comment faire, consultez de nouveau l’étape 1 de la phase 4 de notre tutoriel pour installer Juris-Tyr.

(Rappel des étapes si vous avez acheté votre nom de domaine via OVH : «Connexion à l’ Espace client d’OVH » -> Onglet « WebCloud» -> Lien « Noms de domaines » -> « exemple.com » -> Bouton « Zone DNS » -> Bouton « Créer un nouvel enregistrement » -> Bouton « A » -> Bouton « Suivant » -> « cloud » -> compléter l’adresse IP de votre VPS « 51.xx.xxx.xx » -> « Bouton Suivant » -> « Bouton Valider »).

Une fois votre sous-domaine crée, éditez un nouveau fichier ‘ai.conf’ (ou ‘serge.conf’) dans le dossier /etc/apache2/sites-available/ avec un éditeur de texte en ligne de commande comme Nano :

sudo nano /etc/apache2/sites-available/ai.conf

Copiez et collez le texte suivant dans le fichier :

(Remplacez le texte « ai.exemple.com » par votre propre sous-domaine et nom de domaine)

<VirtualHost *:80>

ServerName ai.exemple.com

#HTTP proxy

# ProxyPreserveHost On

ProxyRequests On

# ProxyRequests Off

ProxyRequests On

# ProxyVia On

<Proxy *>

Allow from all

</Proxy>

ProxyPass / http://127.0.0.1:8008/

ProxyPassReverse / http://127.0.0.1:8008/

<Location "/">

ProxyPass "http://127.0.0.1:8008/"

ProxyPassReverse "http://127.0.0.1:8008/"

</Location>

ErrorLog ${APACHE_LOG_DIR}/ai.exemple.com.error.log

CustomLog ${APACHE_LOG_DIR}/ai.exemple.com.access.log combined

RewriteRule ^/(.*)?$ http://127.0.0.1:8008/$1 [P,L]

</VirtualHost>

Enregistrez et fermez le fichier.

(Pour enregistrer un fichier dans l’éditeur de texte Nano, appuyez sur les touches ‘Ctrl+o’, puis sur ‘Entrer’ pour confirmer. Pour quitter, appuyez sur ‘Ctrl+X’).

Activez ensuite ce nouveau fichier de configuration du serveur Apache ‘hôte virtuel’ :

sudo a2ensite ai.conf

Exécutez la commande suivante pour activer les modules Apache requis :

sudo a2enmod rewrite headers env dir mime setenvif ssl proxy_http proxy rewrite

Recharger Apache et les modules PHP :

sudo systemctl restart apache2 php8.2-fpm

Désormais vous pouvez accèder à Serge via l’adresse : http://ai.exemple.com

3.2. Activez https pour le site internet crée :

Nous souhaitons (un peu) sécuriser l’accès au site ai.example.com. Nous allons donc enregistrer un certificat TLS pour accèder à ce site internet en ‘https’.

Exécutez les commandes suivantes pour installer le client Let’s Encrypt (certbot) à partir du référentiel de logiciels par défaut.

sudo apt install certbot

Si vous utilisez le serveur Web Apache, vous devez également installer le plug-in Certbot Apache.

sudo apt install python3-certbot-apache

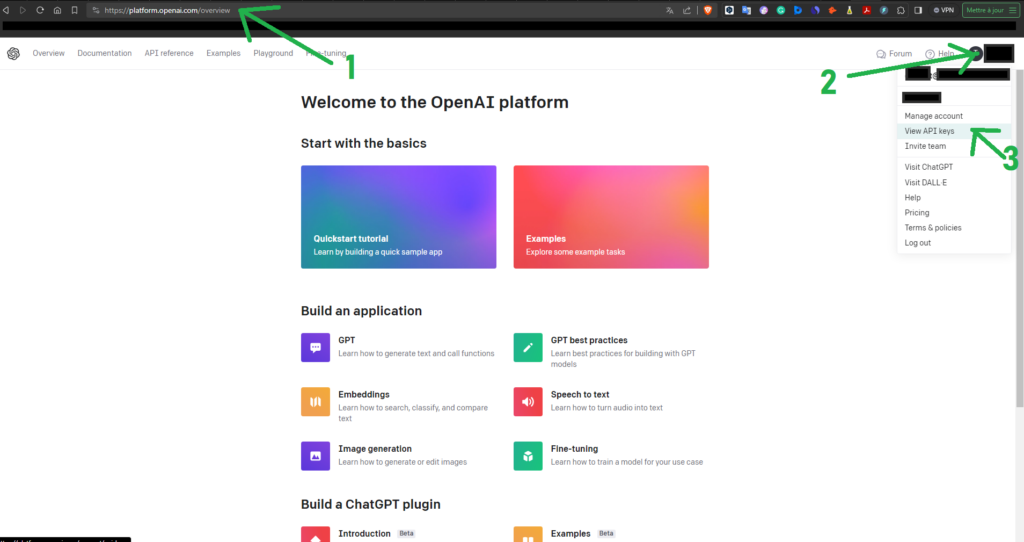

Exécutez ensuite la commande suivante pour obtenir un certificat TLS/SSL gratuit.

sudo certbot --apache --agree-tos --redirect --hsts --staple-ocsp --email yo*@ex*****.com -d ai.example.com

Exécuter la commande suivante

sudo systemctl restart apache2

Etape 4 : Téléchargez un modèle de langage depuis l’interface de Serge

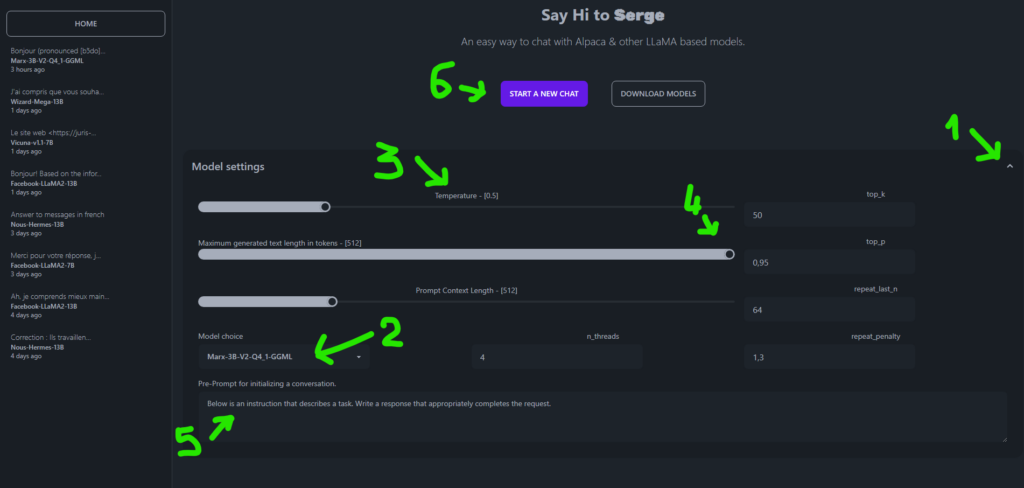

Connetez-vous avec votre navgateur à l’adresse précédemment crée : http://ai.exemple.com ou https://ai.exemple.com puis cliquez sur le bouton « DOWNLOAD MODELS » pour télécharger un modéle de langage :

Téléchargez un modèle de langage, par exemple le modèle Facebook-LLaMA2-7B :

Comment télécharger de nouveaux modèles de langage (llm) (facultatif) :

Des modèles de langage supplémentaires peuvent être ajoutés au volume serge_weights via la commande suivante :

sudo docker cp:docker cp ./my_weight.bin serge:/usr/src/app/weights/

Nous allons justement télécharger des modèles plus légers (et donc plus rapides).

Téléchargez le Modèle « Marx-3B-V2-Q4_1-GGML », c’est un modèle léger et pourtant très efficace en langue anglaise.

Placez vous dans le répertoire ‘home’ du système d’exploitation ‘Ubuntu’ puis exécutez les commandes suivantes :

#revenir dans le répertoir utilisateur home de Ubuntu

cd ~

#télécharger un modele de LLM sur huggingface

sudo wget https://huggingface.co/NikolayKozloff/Marx-3B-V2/resolve/main/Marx-3B-V2-Q4_1-GGML.bin

Ajoutez ce modèle à Serge :

sudo docker cp ./Marx-3B-V2-Q4_1-GGML.bin serge:/usr/src/app/weights/

Créez une nouvelle discussion en sélectionnant ce nouveau modèle téléchargé :

Nous allons également télécharger un modèle de langage plus adapté à la langue française : « Vigogne »

…/…

Ce modèle est accessible via ce lien : https://huggingface.co/TheBloke/Vigogne-2-13B-Instruct-GGML/tree/main

Exécutez à la suite les commandes suivantes :

sudo wget https://huggingface.co/TheBloke/Vigogne-2-7B-Chat-GGML/resolve/main/vigogne-2-7b-chat.ggmlv3.q5_K_M.bin sudo wget https://huggingface.co/TheBloke/Vigogne-2-13B-Instruct-GGML/resolve/main/vigogne-2-13b-instruct.ggmlv3.q5_K_M.bin sudo docker cp ./vigogne-2-13b-instruct.ggmlv3.q5_K_M.bin serge:/usr/src/app/weights/ sudo docker cp ./vigogne-2-7b-chat.ggmlv3.q5_K_M.bin serge:/usr/src/app/weights/

Ces nouveaux modèles de langages adaptés à la langue française apparaissent désormais dans Serge.

…/…

Résultat :

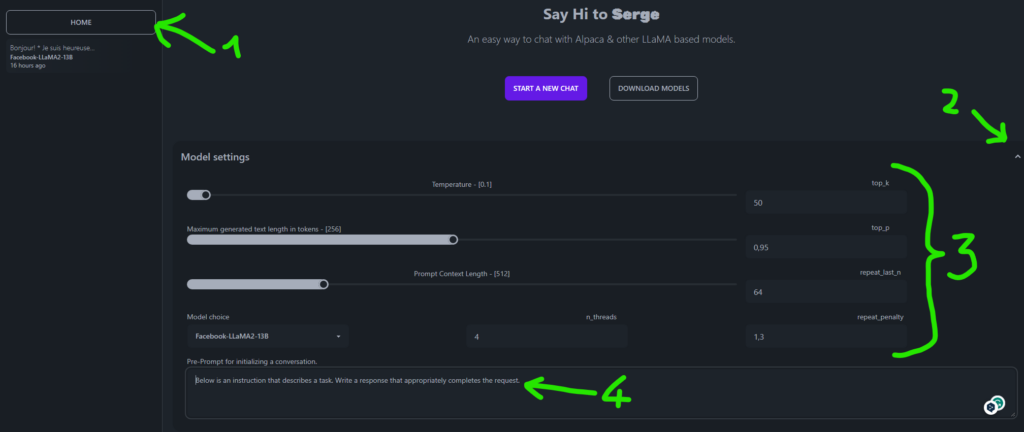

Etape 5 : Paramétrez le modèle de langage et démarrer une nouvelle discussion

Une fois le modèle téléchargé, cliquez sur le bouton « HOME » puis sur la petite flèche de « Model_settings » afin de paramétrer le modèle et indiquer le premier prompt ou la première requête lors du lancement.

- Vous pouvez régler la température à 0,9 ou 1 pour avoir un modèle suffisament créatif dsans ses réponses.

- Vous pouvez régler la longueur du texte à générer à 512

- Vous pouvez régler Prompt_Context_Length jusqu’a 2048. Cependant, si vous n’avez pas beaucoup de mémoire sur votre serveur, éviter d’être top ambitieux avec ce réglage.

- Enfin vous pouvez indiquer le prompt de départ pour le modèle de langage.

…/…

Enfin, cliquez sur le bouton « START_A_NEW_CHAT » et let’s go !

Comment mettre à jour Serge (facultatif) :

Pour mettre à jour Serge, vous devrez

-Soit exécuter la commande suivante :

sudo docker pull ghcr.io/serge-chat/serge:latest

–Soit supprimer le conteneur docker de Serge en exécutant les commandes suivantes, avant de le réinstaller (étape 2 de ce chapitre) :

Lister les conteneurs Docker :

sudo docker ps -a

Une liste de conteneur docker apparaît avec des numéros associés. Copiez le numéro (« ID_CONTENAIR ») associé au docker ‘Serge », puis arrétez-le.

Arretez le conteneur Docker de Serge :

sudo docker stop ID_CONTENAIR

Puis supprimer le :

sudo docker rm ID_CONTENAIR

Lister les images Docker :

sudo docker images

Repérez le numéro de l’image de Serge (‘ID_IMAGE’), puis supprimer la avec la commande suivante :

sudo docker rmi ID_IMAGE

Arretez et supprimez les volumes Docker inutilisés :

sudo docker system prune -a

sudo docker volume prune -a

Puis vous réinstallerez Serge avec docker avec la commande suivante :

sudo docker run -d \ --name serge \ -v weights:/usr/src/app/weights \ -v datadb:/data/db/ \ -p 8008:8008 \ ghcr.io/serge-chat/serge:latest

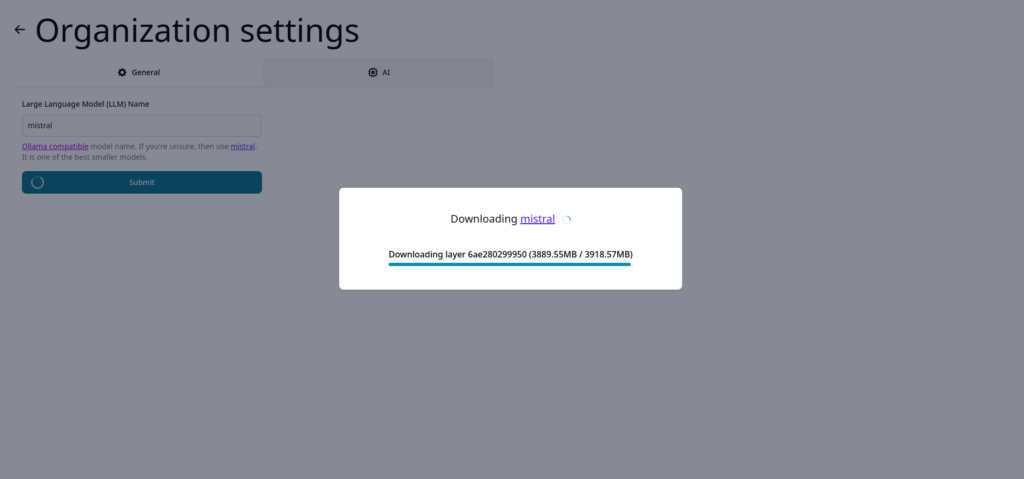

Ollama – Utilisez Llama 2 et MistralAI sur son PC sous Windows ou son Mac ou sur son serveur

Ollama est un logiciel qui vous permet de discuter avec Llama 2 et d’autres modèles. Il s’agit d’un logiciel multiplateforme fonctionnant sous Linux et macOS. Ollama est un logiciel open source, publié sous la licence MIT. Son installation sur un serveur lui permet d’être accessible à toute votre équipe.

URL de l’application : https://ollama.ai

Pour installer ce logiciel sur un serveur linux , il est préférable d’avoir préalablement suivi les chapitres 1 à 3 du tutoriel d’installation de Juris-Tyr. et avoir installé préalablement docker et docker compose.

Ce logiciel nécessite un serveur ou un ordinateur performant, doté de beaucoup de mémoire vive et/ou d’une bonne carte graphique Nvidia récente et performante, pour fonctionner dans de bonnes conditions (ou avoir un Mac avec un processeur M2 ou M3).

Dans ce cadre, nous pouvons vous recommander d’installer ce logiciel open source, par exemple, sur les serveurs dédiés Kimsufi de la société OVHCloud qui offrent de bonne performances à un prix raisonnable (Env. 50 € HT par mois pour un serveur dédié, certes sans carte graphique mais doté de 128 Go de mémoire vive : https://eco.ovhcloud.com/fr/?display=list&memory=128%7C512 ).

Pourquoi privilégier l’installation du logiciel Ollama sur un serveur plutôt que sur un ordinateur personnel ?

L’intérêt d’installer Ollama (ou un autre logiciel d’intelligence artificielle open source tel que SecureAI Tools par exemple), sur un serveur plutôt que sur son ordinateur personnel est de permettre à tous les collaborateurs de votre cabinet d’avocats ou de votre entreprise, d’accéder,de n’importe quel terminal, ordinateur ou téléphone, à un logiciel d’intelligence artificielle performant et en pouvant transmettre des données personnelles ou sensibles sans craindre qu’elles soient captées par la société OpenAI, Microsoft ou par d’autres sociétés commerciales.

Etape 1 : Installation de Ollama

Le créateur de ce logiciel à mis à disposition un script d’installation sur Linux et Mac.

- si vous avez un mac, vous pouvez télécharger Ollama sur cette page : https://ollama.ai/download

- si vous avez un pc sous windows, vous pouvez installer la version preview en cliquant sur ce lien : https://ollama.com/download/OllamaSetup.exe

- Enfin, si vous utilisez linux (Ubuntu, Alpine…etc.) sur votre ordinateur ou sur votre serveur /VPS, vous pouvez exécuter cette commande pour installer Ollama :

sudo curl https://ollama.ai/install.sh | sh

Lançons Ollama au démarrage :

sudo systemctl start ollama

sudo systemctl enable ollama

Ce script va installer Ollama avec tous les progiciels nécessaires…

👍Vous pouvez ensuite procéder à l’installation de l’interface web Ollama Web UI en suivant ce tutoriel.

…/…

Si (et seulement si) le script ci-dessus ne fonctionne pas, vous pouvez alors exécuter les commandes suivantes pour installer Ollama sous linux (avec l’ancienne méthode).

Installer certains autres progiciels :

sudo apt install cmake make golang-go

sudo apt-get install golang

Clonez le référentiel GitHub du projet avec la commande suivante :

cd /var/www/sudo git clone https://github.com/jmorganca/ollamasudo chown www-data:www-data -R /var/www/ollama

Entrez dans le répertoire / dossier nouvellement créé par git :

cd ollamaConstruisez le logiciel:

sudo go build .Démarrez le serveur :

sudo ./ollama serve &Si vous souhaitez exécuter Ollama sans avoir à utiliser ./ollama à chaque fois, ajoutez le répertoire ollama à la variable d’environnement $ PATH.

Le serveur écoute à l’adresse : http://127.0.0.1:11434.

Pour tester le modèle Llama 2, exécutez la commande suivante dans le terminal :

sudo ollama run llama2Ollama procède au téléchargement du modèle Llama 2. C’est un téléchargement de 3,8 Go sur le disque dur.

Une fois installé, la ligne finale affiche l’invite » > > > « dans votre terminal de commande :

127.0.0.1 |POST "api/generate" > > > .../...

Etape 2 : Utilisation

Vous pouvez désormais tester le modèle Llama 2 en tapant la commande ‘sudo ollama run llama2‘, puis votre prompt… après les caractères » > > > » .

Ollama propose une méthode (relativement) simple pour expérimenter les LLM.

Vous pouvez accéder à une variété de modèles avec quelques commandes simples :

ollama pull llama2

ollama pull llama2:13b

ollama pull orca

ollama pull mistral

ollama pull mixtral

Puis, en exécutant les commandes suivantes selon le modèle de langage choisi :

sudo ollama run nous-hermes

sudo ollama runwizard-vicuna

…etc.

Le modèle ‘Open Hermes 2 Mistral’ donne de bons résultats. Pour l’installer, exécutez les commandes suivantes :

sudo ollama run openhermes2-mistral

Appuyez simultanément sur les touches [Control] et [d] pour quitter ollama.

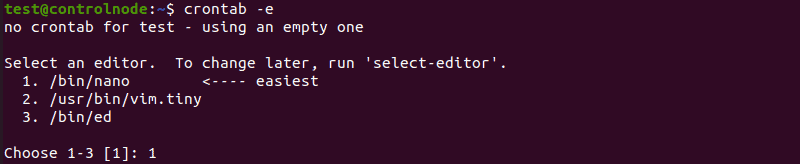

Si vous souhaitez que Ollama se lance à chaque démarrage exécutez la commande suivante :

sudo systemctl enable ollama

Personnalisation d’un modèle de langage :

Vous pouvez également personnaliser les modèles en créant votre propre modèle. La personnalisation vous permet de définir la température et le prompt initial.

Commencez par sélectionner un modèle :

ollama pull llama2

Puis créer un fichier de configuration pour le modèle :

sudo nano Modelfile

Puis complétez le fichier Modelfile avec les commandes suivantes :

FROM llama2

set the temperature to 1 [higher is more creative, lower is more coherent]

PARAMETER temperature 1

set the system prompt

SYSTEM """

You are Harvey Specter from Suits TV show. Answer as Harvey Specter, the legal assistant, only.

"""Ensuite, créez et exécutez le modèle qui s’appellera ‘Suits’ dans l’exemple ci-après :

ollama create Suits -f ./Modelfile ollama run Suits >>> Hello Hello, it's your legal assistant Harvey Specter.

Pour plus d’exemples, consultez le répertoire d’exemples. Pour plus d’informations sur la création d’un fichier de configuration de modèle, consultez la documentation Modelfile.

Vous pouvez également visionner ce tutoriel sur Youtube pour tout savoir sur l’ajout de LLM dans Ollama :

Lister les modèles de langages disponibles :

Pour lister les modèles, exécuter la commande suivante :

ollama list

Supprimer des modèles de langages :

Pour supprimer des modèles, exécutez la commande suivante :

ollama rm llama2

Configurer l’api pour Ollama :

Ollama dispose d’une API pour exécuter et gérer des modèles.

Par exemple pour générer du texte à partir d’un modèle, exécutez la commande suivante :

curl -X POST http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt":"Why is the sky blue?"

}'

Compatibilité de Ollama avec les API de la société OpenAI :

Ollama a désormais une compatibilité intégrée avec les API de la société OpenAI, permettant d’utiliser davantage d’outils et d’applications avec Ollama localement, comme on le fait lorsqu’on utilise une API de la société OpenAi sur divers sites ou logiciels.

Installation :

Commencez par télécharger Ollama et extrayez un modèle tel que Llama 2 ou Mistral :

ollama pull llama2

Utilisation :

Pour appeler le point de terminaison de l’API compatible OpenAI d’Ollama, utilisez le même format OpenAI et remplacez le nom d’hôte par http://localhost:11434 :

curl http://localhost:11434/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "llama2",

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Hello!"

}

]

}'

OpenAI Python library :

from openai import OpenAI

client = OpenAI(

base_url = 'http://localhost:11434/v1',

api_key='ollama', # required, but unused

)

response = client.chat.completions.create(

model="llama2",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Who won the world series in 2020?"},

{"role": "assistant", "content": "The LA Dodgers won in 2020."},

{"role": "user", "content": "Where was it played?"}

]

)

print(response.choices[0].message.content)

OpenAI JavaScript library :

import OpenAI from 'openai'

const openai = new OpenAI({

baseURL: 'http://localhost:11434/v1',

apiKey: 'ollama', // required but unused

})

const completion = await openai.chat.completions.create({

model: 'llama2',

messages: [{ role: 'user', content: 'Why is the sky blue?' }],

})

console.log(completion.choices[0].message.content)

GodMode – AI Chat Browser

Le logiciel GodMode est présenté comme un navigateur de chat dédié donnant un accès instantané aux applications Web complètes de ChatGPT, Bard, Claude 2, Perplexity, Bing, Quora Poe et d’autres services d’IA, tous accessibles avec un seul raccourci clavier. Essentiellement, le logiciel vous permet simplement de discuter simultanément avec une gamme de services d’IA. En un sens, il ressemble un peu à Poe … mais en open-source….

Il n’y a vraiment pas d’installation complexe à réaliser car le projet GitHub fournit une AppImage.

AppImage est un format de logiciel universel sur Linux (et Mac) permettant de distribuer des logiciels portables sous Linux sans avoir besoin d’autorisations de superutilisateur (sudo) pour installer l’application.

AppImage n’installe pas vraiment de logiciel. Il s’agit d’une image compressée avec toutes les dépendances et bibliothèques nécessaires pour exécuter le logiciel souhaité (un peu comme un conteneur Docker).

Pour exécuter le logiciel, téléchargez la dernière version d’AppImage à cette adresse :

https://github.com/smol-ai/GodMode/releases/latest

Puis, si vous utilisez Ubuntu ou linux, rendez le fichier téléchargé exécutable, avec la commande suivante :

Si vous utilisez un micro-ordinateur Raspberry ou OrangePi, exécutez la commande suivante :

sudo chmod u+x GodMode-1.0.0-beta.8-arm64.AppImage

Si vous utilisez un processeur Intel x86, exécutez la commande suivante :

sudo chmod u+xGodMode-1.0.0-beta.8.AppImage

et lancez l’application en cliquant deux fois sur le fichier AppImage pour exécuter le logiciel GodMode.

Le code source complet est également disponible à cette adresse : https://github.com/smol-ai/GodMode

Vous aurez également besoin de renseigner les identifiants des comptes pour la majorité des services d’IA (OpenAI …etc).

GodMode offre un moyen simple d’obtenir rapidement des réponses aux questions et de vérifier les faits. Un large éventail de modèles d’IA est pris en charge, chacun avec ses propres forces et faiblesses. Par exemple, Perplexity est un excellent moyen de vérifier des informations car il génère des citations à partir de sources. Cela vous aide à évaluer l’exactitude des résultats. Claude 2 est utile pour trouver des informations générales, et ChatGPT nous est utile pour les tâches de programmation bien que le code qu’il génère nécessite beaucoup de rectifications. De nouvelles fonctionnalités et moteurs d’IA sont régulièrement ajoutés. La prise en charge initiale de oobabooga/text-generation-webui a également été ajoutée au logiciel.

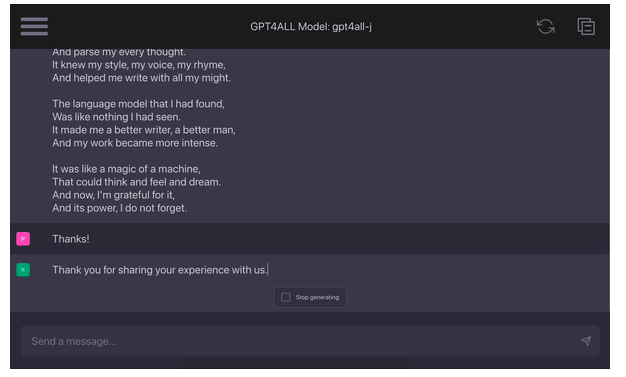

GPT4ALL, un logiciel d’intelligence artificielle à installer sur son PC ou son Mac

GPT4All , à ne pas confondre avec le LLM GPT4 de la société OpenAI, est un logiciel permettant d’utiliser des LLM tels que MistralAI ou Llama 2 sur son PC ou son Mac en local (accessibles que depuis votre ordinateur personnel).

Lien vers l’application : https://github.com/nomic-ai/gpt4all

En résumé, GPT4All est (notamment) une application installable sur Linux, Windows ou Mac Os, qui permet d’utiliser certains modèles de langages. Cette application offre des fonctionnalités similaires à Serge à la différente quelle est exécutée exclusivement sur votre ordinateur. Il vous suffit d’installer l’application correspondante à votre système d’exploitation en cliquant sur ce lien hypertexte : https://github.com/nomic-ai/gpt4all puis de télécharger un des modèles disponibles.

Cette application nécessite d’avoir un ordinateur puissant et beaucoup de mémoire RAM (16 Go). Cependant, il s’agit d’une solution simple pour installer et utiliser en local un logiciel d’intelligence artificielle.

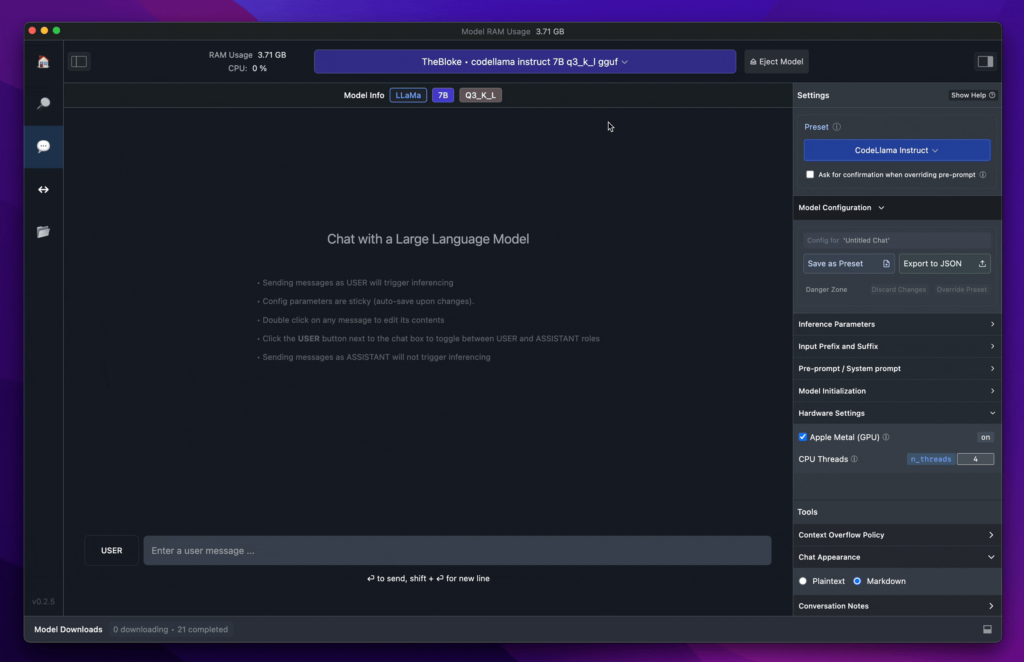

LM Studio, un logiciel d’intelligence artificielle à installer sur son PC sous Windows ou son Mac

Lien vers le site de LMStudio : https://lmstudio.ai/

LM Studio est un autre logiciel que GPT4all qui permet de faire fonctionner des grands modèles de langage (LLM tels que Mistral, Llama2…) sur son PC ou son Mac en local…

LM Studio ne peut pas être installé sur un serveur LM Studio, c’est une application installable sur votre ordinateurpersonnel sous Linux, Windows ou Mac Os, qui permet d’utiliser certains modèles de langages. Cette application offre des fonctionnalités similaires à GPT4all … mais avec plus de fonctionnalités :

Avec LM Studio, vous pouvez…

- 🤖 Exécutez des LLM sur votre ordinateur portable, entièrement hors ligne

- 👾 Utilisez des modèles via l’interface utilisateur de chat intégrée à l’application ou un serveur local compatible OpenAI

- 📂 Téléchargez tous les fichiers de modèles compatibles à partir des référentiels HuggingFace

- 🔭 Découvrir de nouveaux LLM remarquables sur la page d’accueil de l’application

LM Studio prend en charge tous les modèles ggml Llama, MPT et StarCoder sur Hugging Face (Llama 2, Orca, Vicuna, Nous Hermes, WizardCoder, MPT, etc.) Exigences minimales : Mac M1/M2/M3 ou PC Windows avec un processeur prenant en charge AVX2. La version pour les PC sous Linux est disponible en bêta.

Il vous suffit d’installer l’application correspondante à votre système d’exploitation :

…puis de télécharger un des modèles disponibles.

Comme pour GPT4all, cette application nécessite d’avoir un ordinateur puissant et beaucoup de mémoire RAM (16 Go). Cependant, il s’agit d’une solution simple pour installer et utiliser en local (et non sur un serveur) un logiciel d’intelligence artificielle.

Jan : une alternative open source à ChatGPT qui fonctionne 100 % hors ligne sur votre ordinateur

Jan est un logiciel alternatif open source à ChatGPT qui fonctionne 100 % hors ligne sur votre ordinateur sou s Windows, Linux ou sur votre Mac.

Le dépôt Github est accessible via cette page : https://github.com/janhq/jan?tab=readme-ov-file

Jan fonctionne sur n’importe quel matériel :

- Nvidia GPUs (fast)

- Apple M-series (fast)

- Apple Intel

- Linux Debian

- Windows x64

Télécharger :

| Version | Windows | MacOS | Linux | ||

| Stable | jan.exe | Intel | M1/M2 | jan.deb | jan.AppImage |

| Experimental (Nightly Build) | jan.exe | Intel | M1/M2 | jan.deb | jan.AppImage |

Téléchargez la dernière version de Jan sur https://jan.ai/ ou consultez la page GitHub Releases pour télécharger n’importe quelle version précédente.

Demo :

Realtime Video: Jan v0.4.3-nightly on a Mac M1, 16GB Sonoma 14

Comme pour GPT4all ou LMStudio, cette application nécessite d’avoir un ordinateur puissant et beaucoup de mémoire RAM (16 Go minimum). Cependant, il s’agit d’une solution simple pour installer et utiliser en local (et non sur un serveur) un logiciel d’intelligence artificielle avec des LLm open source.

Jan – Liens hypertexte :

Rappel du sommaire principal de Juris-Tyr:

- Chapitre 1 : Avoir un serveur – choisir entre souscrire à un abonnement à serveur dédié (VPS) (recommandé) ou de configurer un ordinateur serveur installé dans vos locaux et votre modem/routeur

- Chapitre 2 : Installez et utiliser le logiciel Putty pour se connecter au serveur depuis votre ordinateur sous Windows ou via un logiciel équivalent si votre ordinateur est un Mac (https://putty.fr.softonic.com/mac/alternatives)

- Chapitre 3 : Installez la pile LAMP (Serveur Apache, Mariadb, Php8.2)

- Chapitre 4 : Installez Nextcloud 27 (Ubuntu 22.04, Apache2, PostgreSQL)

- Chapitre 5 : Installez CollaboraOnline (Suite bureautique de type Office) (facultatif)

- Chapitre 6 : Installez OnlyOffice (Autre suite bureautique de type Office) (facultatif)

- Chapitre 7 : Installez un serveur d’e-mail

- Etape 1 ; Installez d’un serveur Postfix sous Ubuntu 22.04

- Etape 2 : Installez Dovecot

- Etape 3 : Installez Postfixadmin

- Etape 4 : Configurez SPF et DKIM avec Postfix sur Ubuntu

- Etape 5 : Création d’un enregistrement DMARC pour protéger votre nom de domaine contre l’usurpation d’e-mails

- Etape 6 : Comment contourner les blacklists d’adresses IP de Microsoft Outlook et des autres fournisseurs d’adresses e-mails

- Etape 7 : Installez le webmail Roundcube (application de messagerie en ligne)

- Etape 8 : Comment limiter le risque que vos e-mails soient classés dans les spams (facultatif)

- Etape 9 : Installez les logiciels antivirus Amis et ClamAv sur Ubuntu (facultatif)

- Chapitre 8 : Installez InvoiceNinja (Logiciel de devis, facturation et paiement en ligne des factures)

- Chapitre 9 : Installez PDFsignature (Logiciel de modification en ligne de fichiers PDF)

- Chapitre 10 : Installez Firefly III et du module d’import automatique de relevés bancaires (Logiciel de comptabilité) (facultatif)

- Chapitre 11 : Installez WordPress (Logiciel de création et d’édition de site internet) (facultatif)

- Chapitre 12 : Installez Jitsi Meet (Logiciel de visioconférence auto-hébergé) (facultatif)

- Chapitre 13 : Installez Serge (Logiciel permettant d’utiliser des modèles d’intelligence artificielle open-source basés sur LLaMA2) (facultatif)

- Chapitre 14 : Installez LibreChat (Logiciel permettant d’utiliser des logiciels d’intelligence artificielle de OpenAI, Anthropic via leur clé d’API) (facultatif)

- Chapitre 15 : Installez Web Whisper + (Logiciel de reconnaissance vocale en ligne) (facultatif)

- Chapitre 16 : Installez SecureAI Tools (Interroger vos fichiers PDF avec un logiciel IA open-source auto hébergé sur votre serveur pour garantir la confidentialité de vos données) (facultatif)

- Chapitre 17 : Installez Web-speech-synthesis-and-recognition, un logiciel pour convertir la parole en texte et vice versa en quelques secondes

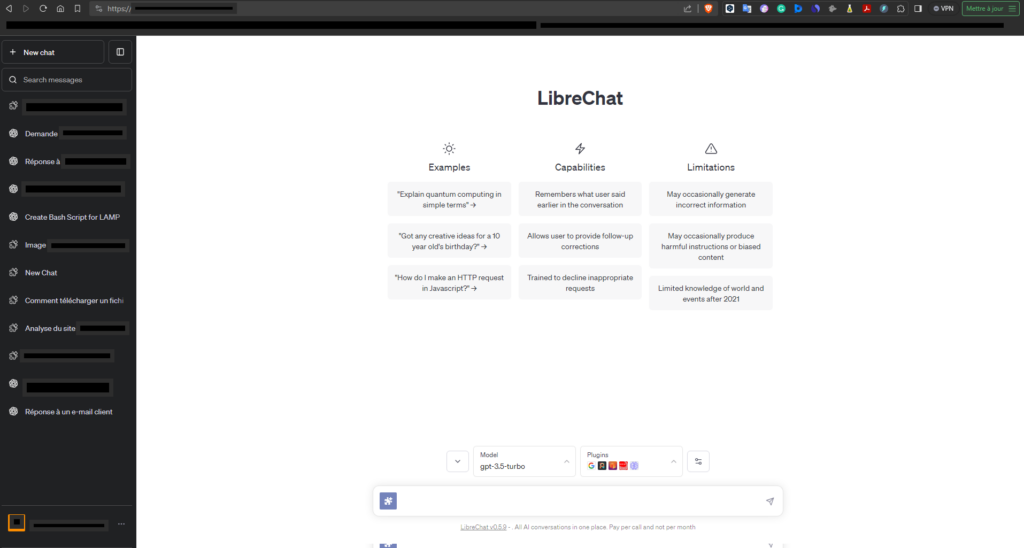

LibreChat

LibreChat est une application open-source qui vous permet d’utiliser plusieurs modèles et logiciels d’intelligence artificielle de sociétés commerciales (OpenAi, Bing, Anthropic…) depuis un site internet hébergé sur votre serveur.

Le dépôt logiciel de cette application est accessible via cette page : https://github.com/danny-avila/LibreChat/tree/main

Ce logiciel intègre et améliore également les fonctionnalités originales du client d’OpenAI telles que la recherche de conversations et de messages, les modèles d’invite et les plugins.

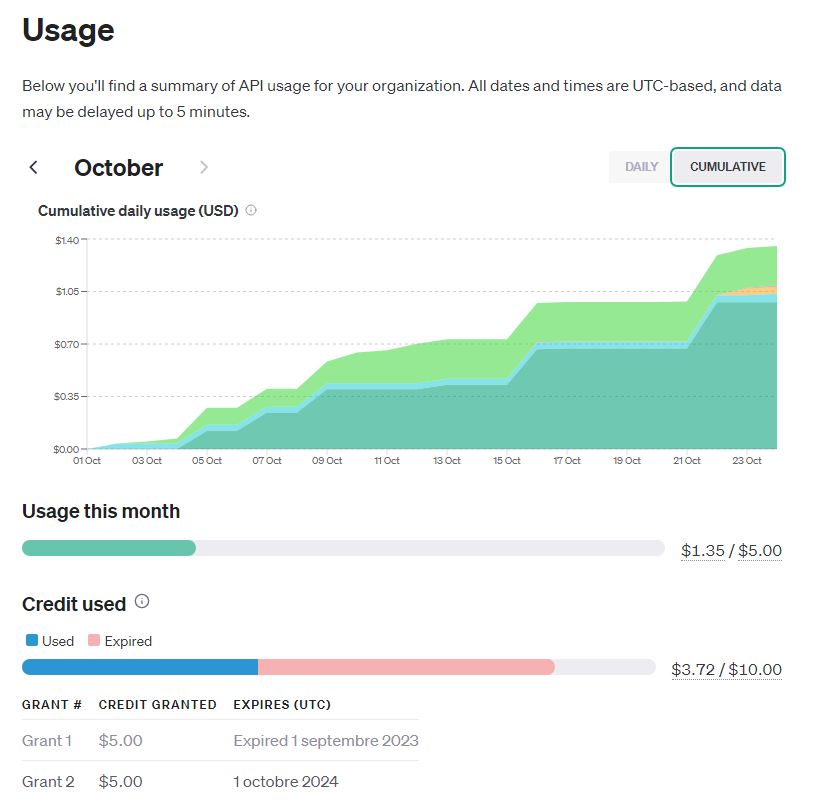

Avec LibreChat, vous n’avez plus besoin d’opter pour un abonnement ChatGPT Plus à 20$ par mois et vous pouvez plutôt utiliser des API gratuites (ou payantes à partir de 5$ par mois si vous dépassez la durée de test de 3 mois d’OpenAI par exemple).

🪟 Ce logiciel peut être installé sur un serveur tel qu’expliqué dans ce tutoriel ,ou en local, uniquement sur votre pc sous Windows en téléchargeant et exécutant le script téléchargeable sur cette page : https://github.com/fuegovic/LibreChat-Windows-Installer/releases/tag/v0.3.3

Caractéristiques :

- Streaming de réponses identique à ChatGPT via des événements envoyés par le serveur Interface utilisateur de ChatGPT d’origine, y compris le mode sombre

- Sélection de modèles d’IA : API OpenAI, BingAI, navigateur ChatGPT, PaLM2, Anthropic (Claude), plugins

- Créer, enregistrer et partager des préréglages personnalisés

- Modifier et renvoyer des messages avec branchement de conversation

- Rechercher tous les messages/conversations

- Plugins disponibles (y compris l’accès Web, la génération d’images et plus encore…

…/…

Nous vous recommandons de lire notre article sur nos conseils d’utilisation des logiciels d’intelligence artificielle par les avocats si vous utilisez régulièrement des applications d’intelligence artificielle ou des sites internet de sociétés commerciales telles que OpenAi, Claude, Google/Bard…

En effet, même en utilisant ChatGPT ou GPT4 via une API, la société OpenAI (et les autres sociétés) collectent toutes vos données !

Mise à jour importante : La société OpenAI a annoncé en mars 2023 que les données soumises par l’intermédiaire de l’API n’étaient plus utilisées pour former et améliorer les modèles d’OpenAI.

Si vous utilisez ChatGPT 3.5 ou GPT-4 via l’API d’OpenAI et l’application opensource « Librechat », vos données ne devraient pas, en principe, être utilisées par la société OPENAI (…par contre elles lui seront forcément transmises pour permettre le fonctionnement du logiciel…).

https://www.zdnet.fr/actualites/openai-une-api-chatgpt-pour-les-developpeurs-39954902.htm

« La confiance n’exlcue pas le contrôle » (Staline). La difficulté étant que dans le cas de la société OpenAI et des modèles GPT4 très performants, il n’y a actuellement concrêtement aucun moyen de contrôler que cette socciété n’utilise pas ou plus vos données pour former et améliorer les modèles.

Enfin, la Société OpenAI, comme toutes les sociétés américaines, est soumise au Foreign Intelligence Act (En résumé, les administrations américaines peuvent obtenir toutes les données des clients des sociétés américaines, que ces clients soient de nationalité américaine ou étrangère, du moment que les serveurs informatiques, même installés dans un pays étranger tel que la France, l’Espagne… appartiennent à une société américaine…).

Installez les progiciels nécessaires (s’ils ne sont pas déjà installés) :

Exécutez en premier la commande suivante pour vérifier et installer les mise à jour :

sudo apt update

sudo apt upgrade

Installez apache2 :

sudo apt install -y apache2 apache2-utils

sudo systemctl start apache2

sudo systemctl enable apache2

sudo iptables -I INPUT -p tcp --dport 80 -j ACCEPT

sudo iptables -I INPUT -p tcp --dport 443 -j ACCEPT

Créez un fichier de configuration servername.conf :

sudo nano /etc/apache2/conf-available/servername.conf

Ajoutez dans le fichier /etc/apache2/conf-available/servername.conf la ligne suivante :

ServerName localhostEnregistrez et fermez le fichier : Pour enregistrer un fichier dans l’éditeur de texte « Nano », appuyez sur les touches Ctrl + O (pour ‘Oui’) ou sur Ctrl + Y (pour ‘Yes), puis appuyez sur Entrée pour confirmer.

Pour quitter l’éditeur de texte ‘Nano’, appuyez sur les touches : Ctrl + X.

Activez ensuite ce fichier de configuration sous le serveur Apache avec la commande suivante :

sudo a2enconf servername.conf

Rechargez Apache pour que la modification prenne effet :

sudo systemctl reload apache2

Installez Docker :

sudo apt-get update

sudo apt-get install ca-certificates curl

sudo install -m 0755 -d /etc/apt/keyrings

sudo curl -fsSL https://download.docker.com/linux/ubuntu/gpg -o /etc/apt/keyrings/docker.asc

sudo chmod a+r /etc/apt/keyrings/docker.asc

echo \

"deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.asc] https://download.docker.com/linux/ubuntu \

$(. /etc/os-release && echo "$VERSION_CODENAME") stable" | \

sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

sudo apt-get update

sudo apt-get install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

Installez Docker Compose :

Docker Compose est un outil qui permet de configurer facilement des applications ou des services complexe composés de divers conteneurs. Pour installer Docker Compose sur votre système Ubuntu, téléchargez la version la plus récente (à partir du site officiel) et exécutez la commande suivante:

sudo curl -L « https://github.com/docker/compose/releases/download/1.26.2/docker-compose-$(uname -s)-$(uname -m) » -o /usr/local/bin/docker-compose

Après avoir installé Docker Compose, donnez-lui les autorisations nécessaires pour qu’elle puisse être exécutée correctement:

sudo chmod +x /usr/local/bin/docker-compose

Une fois l ‘installation terminée, vous pouvez exécuter le service Docker sur votre système en exécutant la commande :

sudo systemctl start docker

sudo systemctl enable docker

Installez Conda /miniconda :

sudo wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

Ou si vous avez un Raspberry 4 ou 5 ou un OrangePi 5, executez la commande suivante :

sudo wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-aarch64.sh

Puis, exécutez la commande suivante :

sudo bash Miniconda3-latest-Linux-x86_64.sh

Ou si vous avez un Raspberry 4 ou 5 ou un OrangePi 5, executez la commande suivante :

sudo bash Miniconda3-latest-Linux-aarch64.sh

Installez Yarn :

sudo npm install --global yarn

Installez git :

sudo apt install git

Installez FFmpeg :

sudo apt install ffmpeg

Installez Python :

sudo apt update

sudo apt install build-essential zlib1g-dev libncurses5-dev libgdbm-dev libnss3-dev libssl-dev libreadline-dev libffi-dev libsqlite3-dev wget libbz2-dev

sudo wget https://www.python.org/ftp/python/3.11.3/Python-3.11.3.tgz

sudo tar -xf Python-3.11.3.tgz

cd Python-3.11.3

sudo ./configure --enable-optimizations

sudo make -j 12

sudo make altinstall

Si vous avez une carte graphique Nvidia Rtx, installez Cuda :

sudo su

wget https://developer.download.nvidia.com/compute/cuda/12.4.0/local_installers/cuda_12.4.0_550.54.14_linux.runsudo sh cuda_12.4.0_550.54.14_linux.run

Installer Node.js et NPM :

sudo apt update

sudo apt-get install nodejs

sudo apt install npm

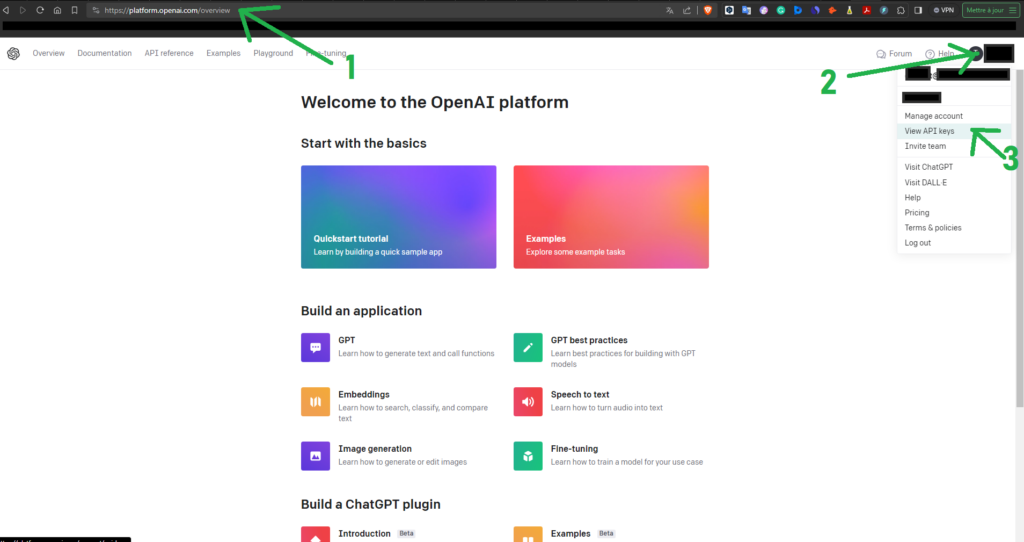

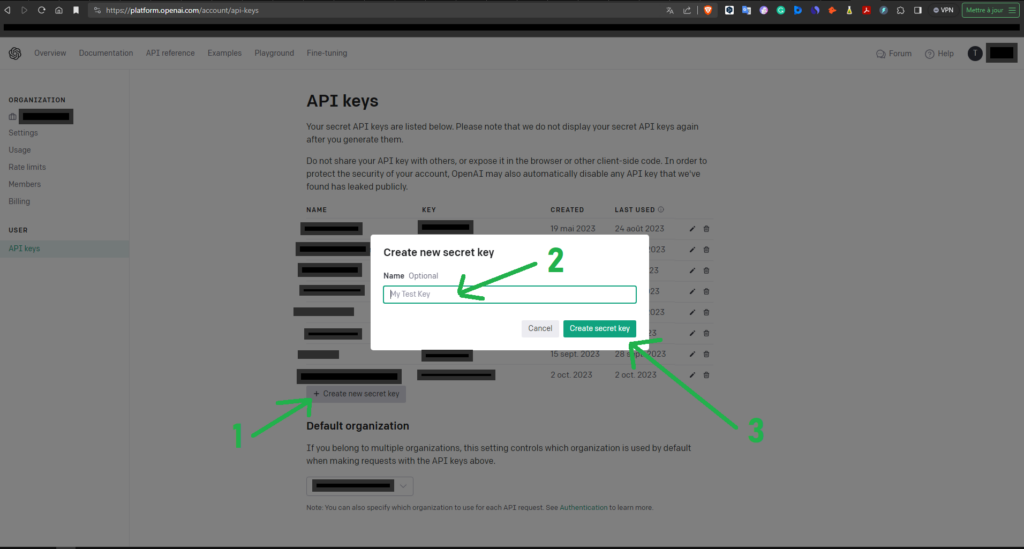

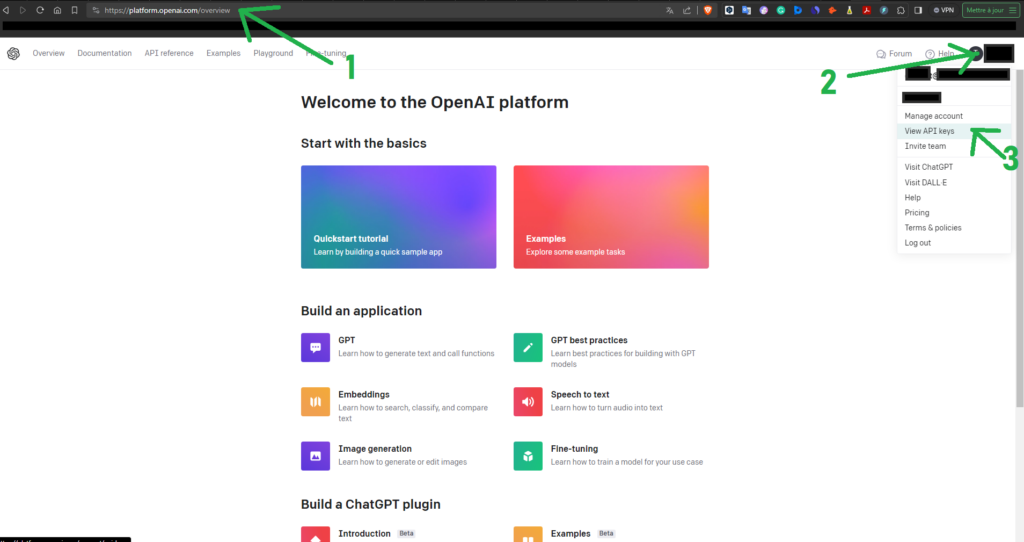

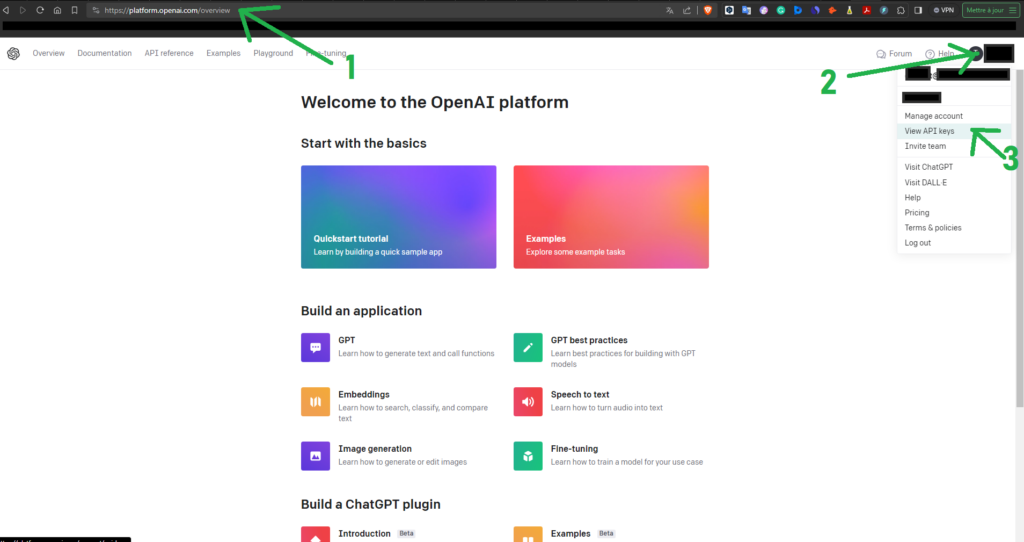

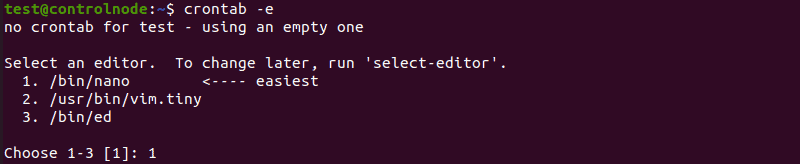

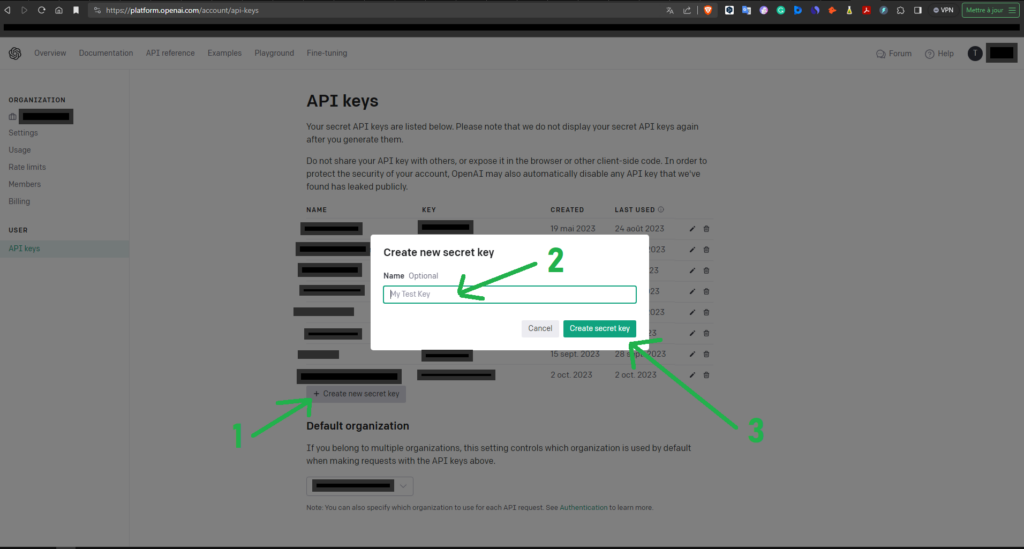

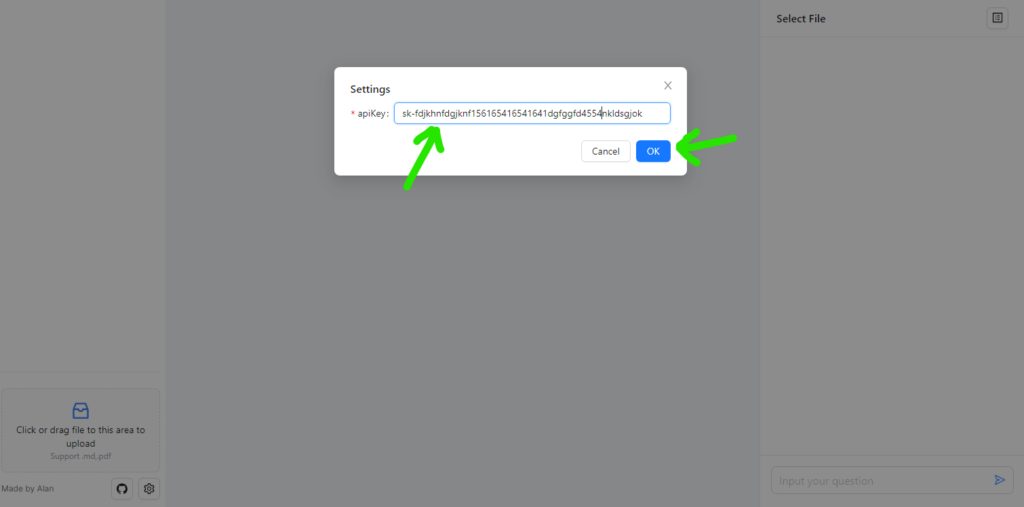

Etape 1 : Connectez-vous sur le site de la société OpenAI pour créer une clé API

Premièrement, vous allez vous connecter sur le site de la société OpenAI, le cas échéant en souscrivant un nouveau compte, afin de créer une clé d’API.

Les étapes sont les suivantes :

- 1 – Connectez-vous à votre compte à l’adresse : https://platform.openai.com/account/api-keys

- 2 – Cliquez sur votre compte utilisateur sur l’icone en haut à droite

- 3 – Cliquez sur « View_API_Keys »

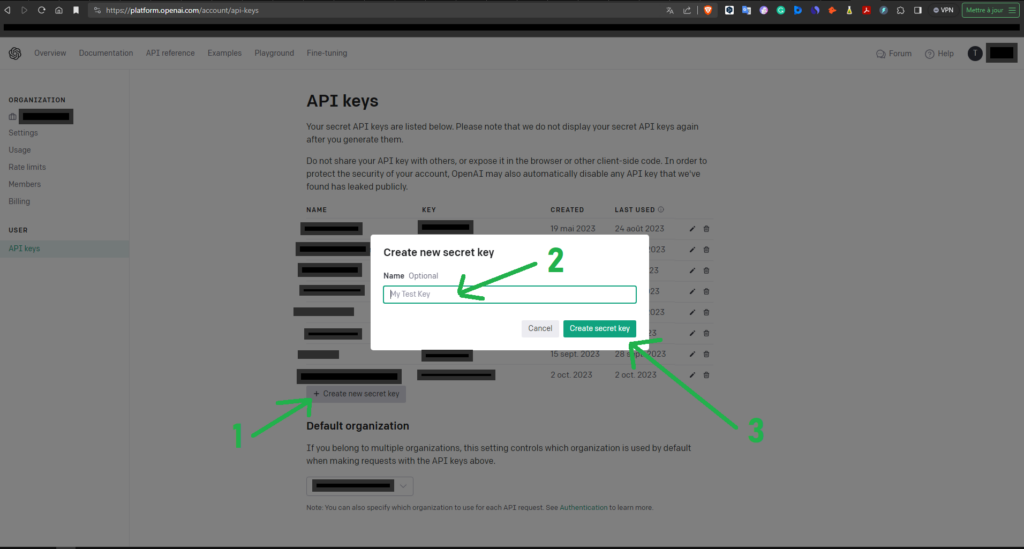

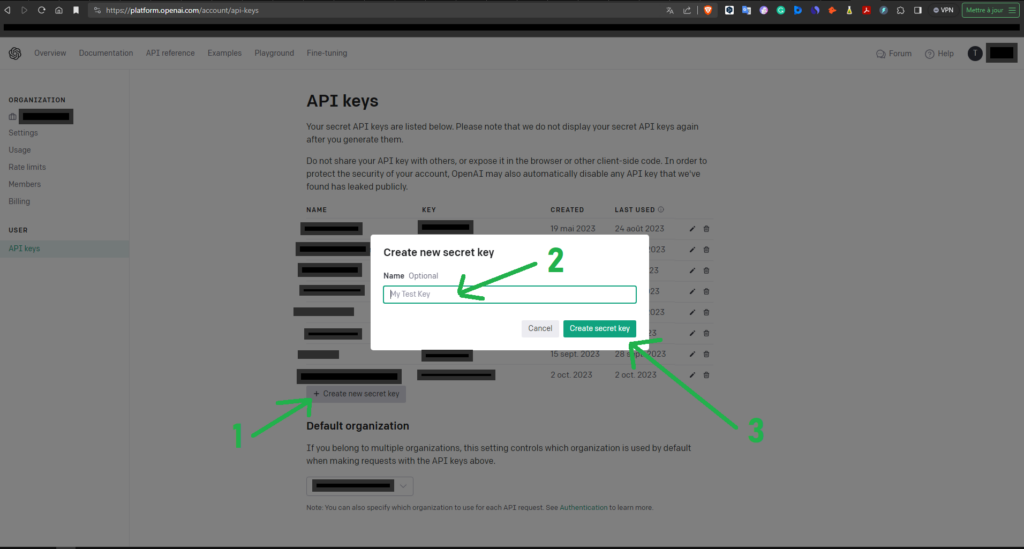

Etape 2 : Créez une clé API sur le site internet d’OpenAI

- 1 – Cliquez sur le bouton « +_Create_new_secret_key«

- 2 – Définissez un nom pour votre clé d’API, par exemple « LibreChat »

- 3 – Cliquez sur le bouton « Create_secret_key«

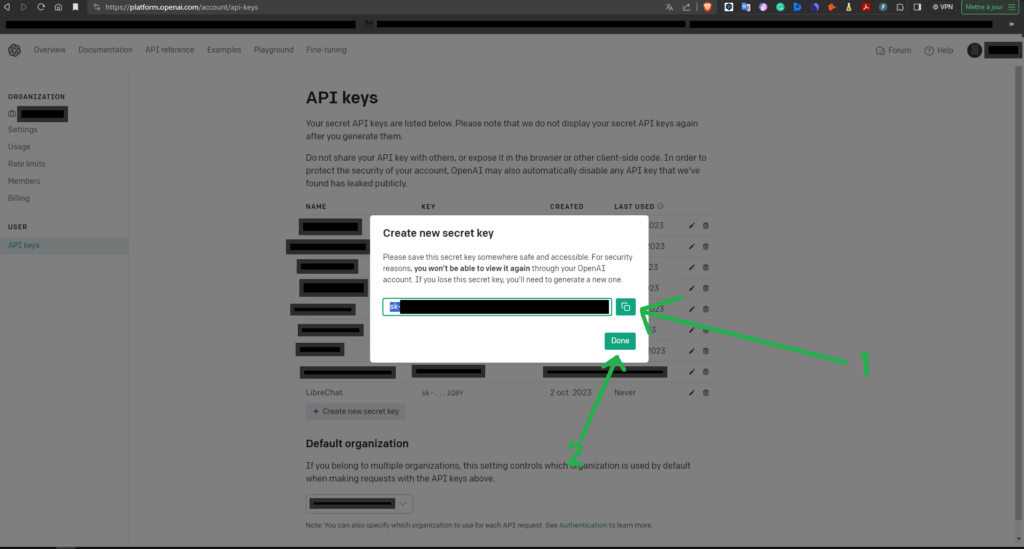

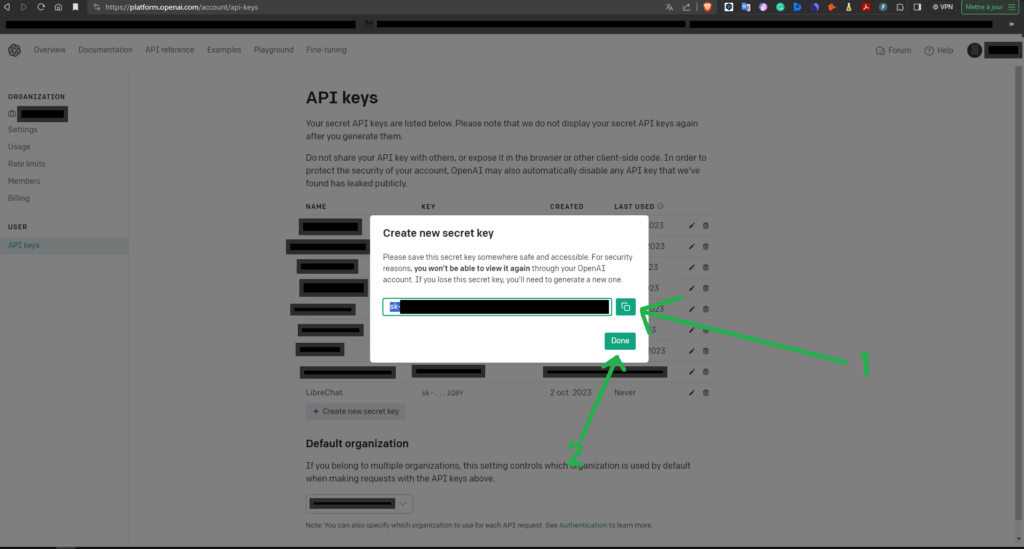

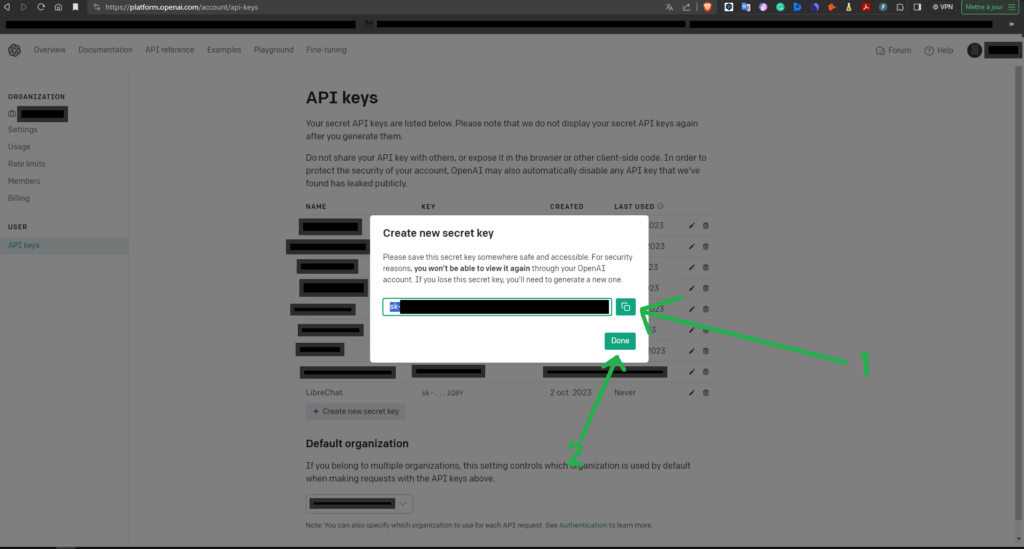

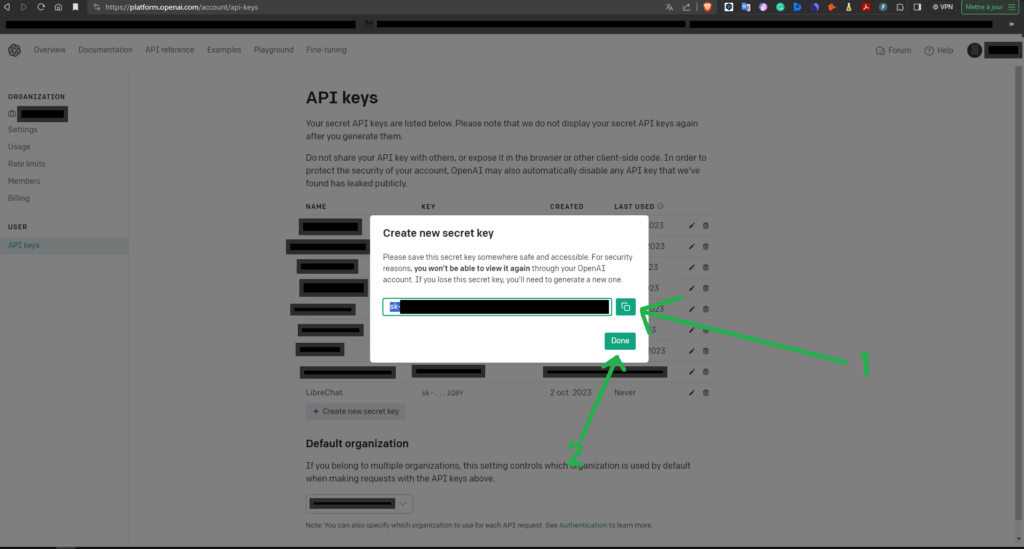

Etape 3 : Copiez / enregistrez votre clé API

1 – Cliquez sur le bouton « Copier » pour copier la clée d’API. La clé commence par les lettres « sk » suivies d’un tiret puis d’une suite de caractères.

- 2 – Cliquez sur le bouton ‘Done’

- 3 – Collez / Enregistrez la clé dans un fichier texte ou dans votre gestionnaire de mot de passe.

Etape 4 : Installez LibreChat

Lancez un terminal Putty et connectez-vous en ssh à votre serveur, ou votre VPS, puis exécutez les commandes suivantes.

sudo ufw 3080,7700,27017,27018/tcp

cd /var/www/html/

sudo git clone https://github.com/danny-avila/LibreChat.git

cd LibreChat

sudo cp .env.example .env

Editez le fichier de configuration :

sudo nano .env

Rechercher la ligne « OPENAI_API_KEY=user_provided » dans ce fichier .env, puis collez votre clé d’API précédemment crée à la place de « user_provided »

Sortie (exemple) :

OPENAI_API_KEY=sk-524154fssfd25454fsgd122454Enregistrez puis fermer le fichier .env en appuyant simultanément sur les touches [Control] et [x] de votre clavier, puis sur la touche [o] ou [y], puis sur la touche [Enter].

Exécuter la commande suivante :

sudo docker compose up

…Patientez, l’installation de LibreChat prend du temps…

Une fois l’installation terminée vous pouvez vous connecter à LibreChat en tapant dans le navigateur de votre serveur l’adresse : http://locatlhost:3080.

Cependant nous allons créer un site internet pour pouvoir y accéder de n’importe où.

De plus, si vous avez installé LibreChat sur un VPS vous ne pourrez pas accédez à cette adresse IP locale : http://locatlhost:3080. ou à l’adresse locale de l’ordinateur : http://192.168.0.XX:3080.

Il faut donc créer une page web dédiée pour accèder à cette application.

Etape 5 : Créez un fichier Virtualhost pour le serveur Apache

5.1. Créez un nom de domaine : librechat.exemple.com

Pour accéder à LibreChat depuis un site internet, vous devez d’abord créer un sous-domaine : par exemple « librechat.exemple.com » ou « chat.exemple .com » depuis votre compte client de votre gestionnaire de nom de domaine en le reliant à l’adresse IP de votre serveur via un enregistrement ‘DNS A’.

Si vous ne vous vous souvenez plus comment faire, consultez de nouveau l’étape 1 de la phase 4 de notre tutoriel pour installer Juris-Tyr.

(Rappel des étapes si vous avez acheté votre nom de domaine via OVH : «Connexion à l’ Espace client d’OVH » -> Onglet « WebCloud» -> Lien « Noms de domaines » -> « exemple.com » -> Bouton « Zone DNS » -> Bouton « Créer un nouvel enregistrement » -> Bouton « A » -> Bouton « Suivant » -> « cloud » -> compléter l’adresse IP de votre VPS ou de votre serveur « 51.xx.xxx.xx » -> « Bouton Suivant » -> « Bouton Valider »).

5.2. Créez un fichier de configuration apache :

Une fois votre sous-domaine crée, éditez un nouveau fichier ‘ai.conf’ ou ‘librechat.conf’ dans le dossier /etc/apache2/sites-available/ avec un éditeur de texte en ligne de commande comme Nano :

sudo nano /etc/apache2/sites-available/librechat.conf

Copiez et collez le texte suivant dans le fichier :

(Remplacez le texte « librechat.exemple.com » par votre propre sous-domaine et nom de domaine)

<VirtualHost *:80>

ServerName librechat.exemple.com

#HTTP proxy

ProxyPreserveHost On

ProxyRequests On

<Proxy *>

Allow from all

</Proxy>

ProxyPass / http://127.0.0.1:3080/

ProxyPassReverse / http://127.0.0.1:3080/

RewriteRule ^/(.*)?$ http://localhost:3080/$1 [P,L]

ProxyPass / http://127.0.0.1:7700/

ProxyPassReverse / http://127.0.0.1:7700/

ProxyPass / http://127.0.0.1:27017/

ProxyPassReverse / http://127.0.0.1:27017/

ProxyPass / http://127.0.0.1:27018/

ProxyPassReverse / http://127.0.0.1:27018/

#Header always unset X-Frame-Options

#RequestHeader set "X-Forwarded-Proto" expr=%{REQUEST_SCHEME}

#RequestHeader set "X-Forwarded-SSL" expr=%{HTTPS}

</VirtualHost>

Enregistrez et fermez le fichier.

(Pour enregistrer un fichier dans l’éditeur de texte Nano, appuyez sur les touches ‘Ctrl+o’, puis sur ‘Entrer’ pour confirmer. Pour quitter, appuyez sur ‘Ctrl+X’).

Activez ensuite ce nouveau fichier de configuration du serveur Apache ‘hôte virtuel’ :

sudo a2ensite librechat.conf

Exécutez la commande suivante pour activer les modules Apache requis :

sudo a2enmod rewrite headers env dir mime setenvif ssl proxy_http proxy rewrite

Recharger Apache et les modules PHP :

sudo systemctl restart apache2 php8.2-fpm

Désormais vous pouvez accèder à LibreChat en tapant l’adresse suivante dans votre navigateur : https://librechat.exemple.com

5.3. Activez un accès via ‘https’ pour le site internet permettant d’utiliser l’application LibreChat (facultatif) :

Nous allons activer une connexion en ‘https’ vers le site internet nouvellement créé

Exécutez les commandes suivantes pour installer le client Let’s Encrypt (certbot) à partir du référentiel de logiciels par défaut.

sudo apt install certbot

Si vous utilisez le serveur Web Apache, vous devez également installer le plug-in Certbot Apache.

sudo apt install python3-certbot-apache

Exécutez ensuite la commande suivante pour obtenir un certificat TLS/SSL gratuit.

sudo certbot --apache --agree-tos --redirect --hsts --staple-ocsp --email yo*@ex*****.com -d librechat.example.com

Enfin, exécuter la commande suivante pour redémarrer le serveur Apache

sudo systemctl restart apache2

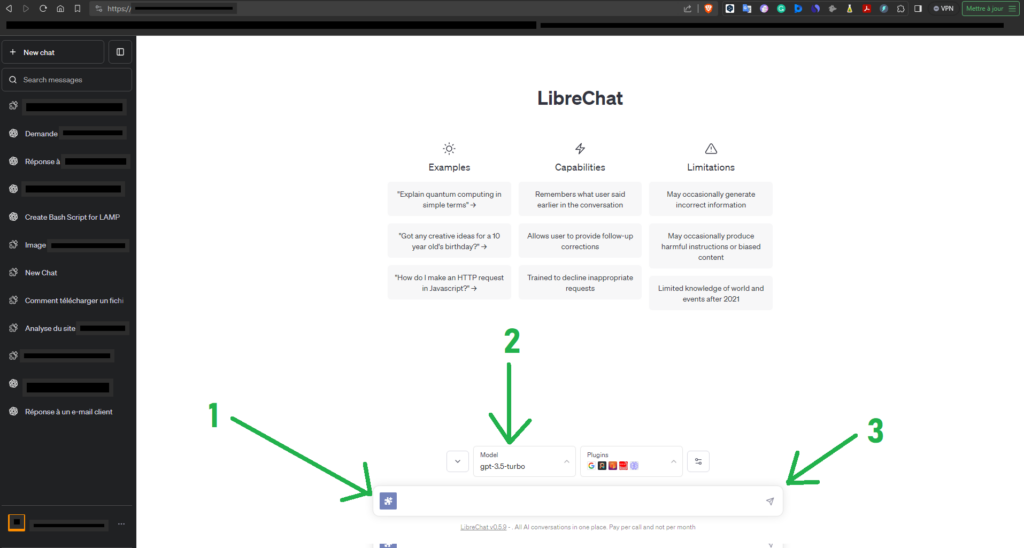

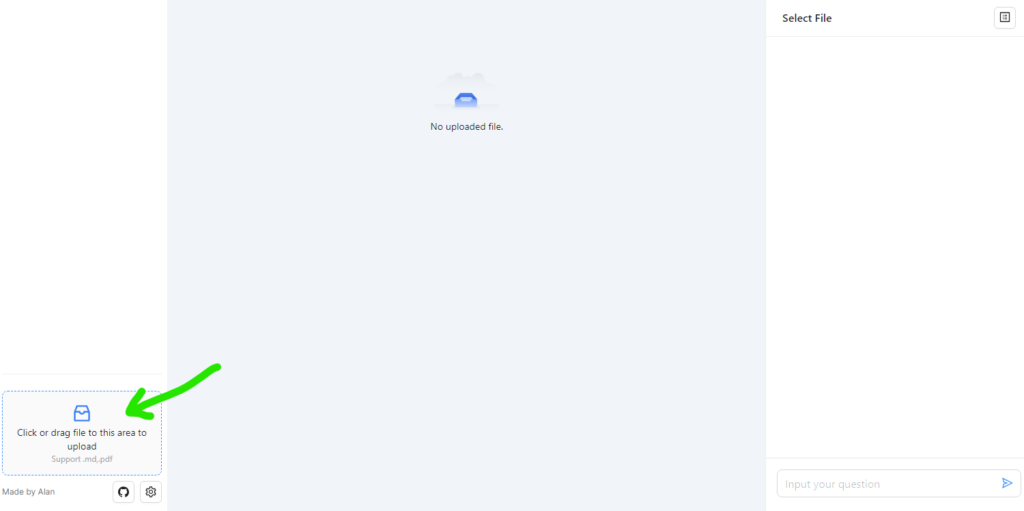

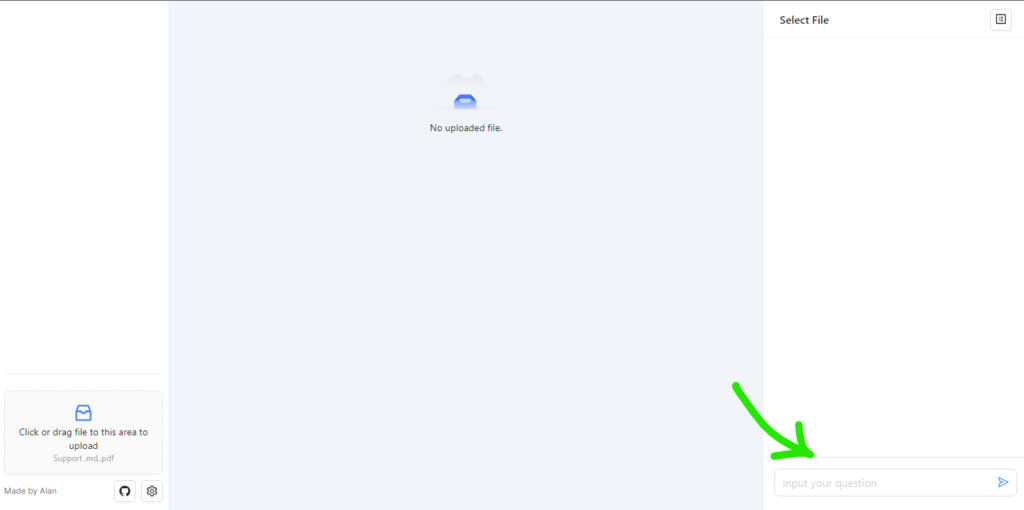

Etape 6 : Utilisez LibreChat

Connectez-vous au site : https://librechat.exemple.com

Après avoir crée un nouveau compte, l’interface de LibreChat vous permet :

- 1 – D’activer ou non des plugins (Recherche sur internet, analyse de site web, …) ;

- 2 – De sélectionner le modèle de langage entre GPT-3.5-turbo ou GPT4 (OU Claude ou Bard si vous disposez d’une Clé API, à renseigner dans le fichier .env comme nous l’avonds fait pour la clé API d’OpenAI) ;

- 3 – D’envoyer vos prompts.

Pourquoi privilégier l’installation d’une application telle que LibreChat plutôt que d’utiliser le site internet de la société OpenIA ?

Il est plus intéressant sur le plan économique d’utiliser une application telle que LibreChat car le coût de l’utilisation d’une clé API est souvent moins important que celui de l’abonnement à GPT4 à environ 20$ par mois…

En effet, le coût mininal mensuel d’une clé API d’OpenAI est seulement de 5$ … par mois, or ce montant de 5$ est en général suffisant pour une utilisation ‘normale’ de ChatGPT ou de GPT4.

En résumé, vous économisez 15$ par mois sur votre utilisation de ChatGPT Plus ou GPT4 avec cette solution.

…/…

Par contre, nous préconisons les mêmes recommandations concernant l’anonymisation des données personnelles lorsque vous utilisez LibreChat ou le site internet de la société OpenAI : https://chat.openai.com/ .

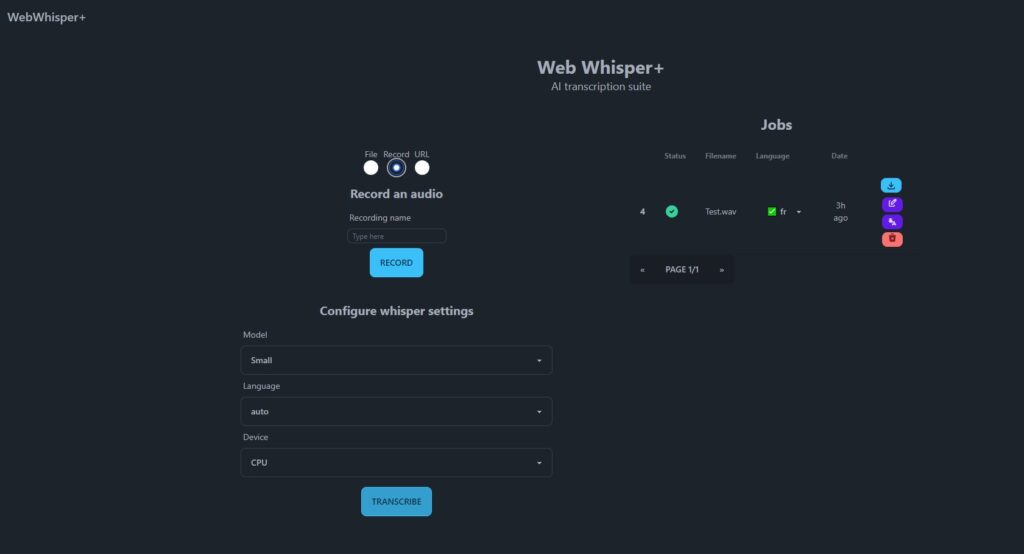

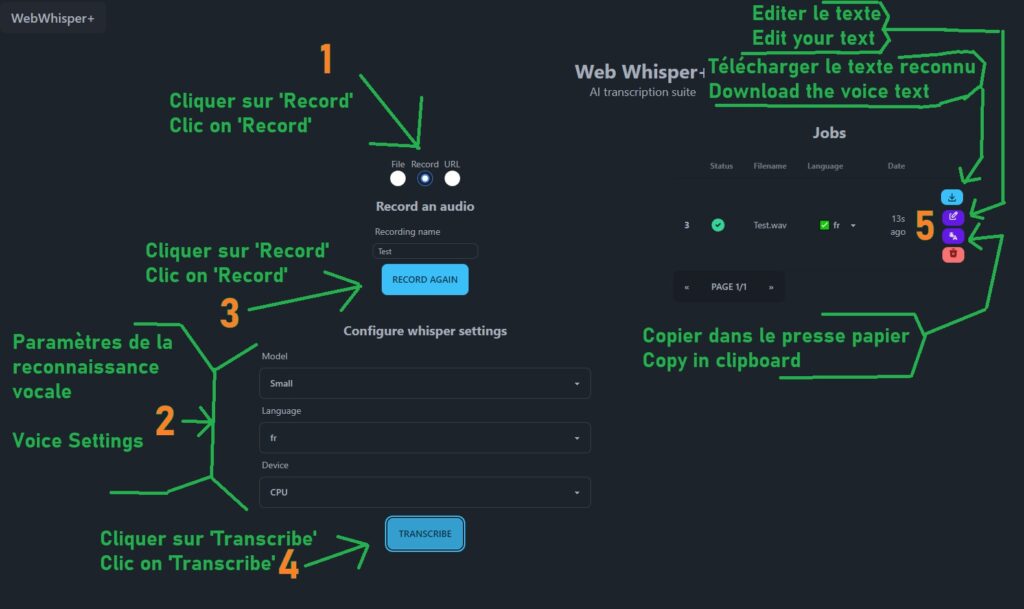

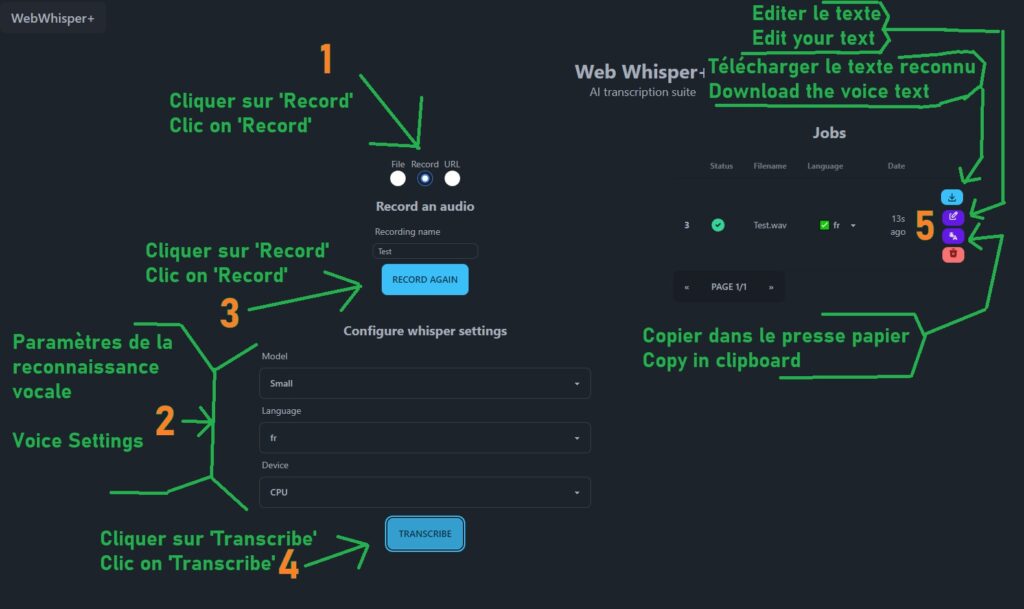

Web Whisper + | Logiciel de reconnaissance vocale en ligne

.

« Whishper » ou « Web Whisper + » est un logiciel open-source à installer sur un serveur ou sur un ordinateur sous linux qui vous permet d’enregistrer et transcrire l’audio directement depuis votre navigateur.

En résumé, il s’agit d’un logiciel de reconnaissance vocale, accessible depuis n’importe quel ordinateur ou smartphone connecté à internet.

Le dépot Github (logiciel) initial est accessible via cette URL : https://codeberg.org/pluja/web-whisper-plus

et pour le nouveau dépot logiciel, à cette URL : https://whishper.net/guides/install/

Cependant, nous allons utiliser le dépot logiciel initial car il permet d’utiliser le micro de l’ordinateur pour effectuer la reconnaissance vocale. Le nouveau dépot ne permet a priori ‘que’ de transcrire de l’audio à partir d’un lien (Youtube par exemple) ou d’un fichier.

Ce logiciel se base sur le progiciel Whisper de la société OpenAI mais vos données ne sont pas envoyées sur les serveur de la société OpenAI puisque le logiciel en lui-même, les données vocales, ainsi que les modèles audio utilisés (small, large…) sont uniquement enregistrés sur votre serveur.